-

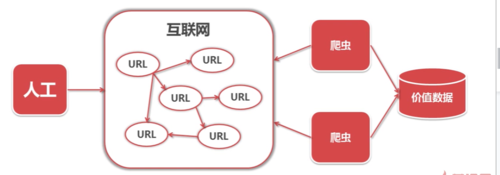

爬虫:一段自动抓取互联网信息的程序

查看全部

查看全部 -

这个使用Python3.0写的,可以实现。

import urllib.request

import http.cookiejarurl = "http://www.baidu.com"

print("--------------------------------------first------------------------------------------------------------")

response1 = urllib.request.urlopen(url)

print(response1.getcode())

print(len(response1.read()))print("---------------------------------------second---------------------------------------------------------")

request = urllib.request.Request(url)

request.add_header("user-agent","Mozilla/0.5")

response2 = urllib.request.urlopen(url)

print(response2.getcode())

print(len(response2.read()))print("--------------------------------------third-----------------------------------------------------------")

cj = http.cookiejar.CookieJar()

opener = urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

urllib.request.install_opener(opener)

response3 = urllib.request.urlopen(url)

print(response3.getcode())

print(len(response3.read()))

print(cj)查看全部 -

python37下成功运行

from urllib import request

from http import cookiejar

url = "http://www.baidu.com"

print("方法1")

response1 = request.urlopen(url)

print(response1.getcode())

print(len(response1.read()))

print("\n方法2")

rq = request.Request(url)

rq.add_header("agent", "Mozilla/5.0")

response2 = request.urlopen(rq)

print(response2.getcode())

print(len(response2.read()))

print("\n方法3")

cj = cookiejar.CookieJar()

opener = request.build_opener(request.HTTPCookieProcessor(cj))

request.install_opener(opener)

response3 = request.urlopen(url)

print(response3.getcode())

print(cj)

print(len(response3.read()))

查看全部 -

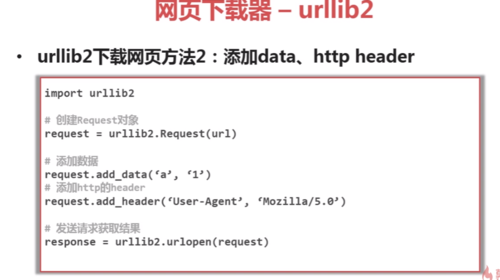

urllib2方法2

查看全部

查看全部 -

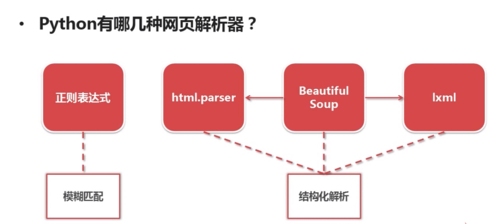

获取所需元素

查看全部 -

三种方法 记个笔记

查看全部 -

爬虫技术的价值,数据提取后分类整合。

查看全部 -

啊啊啊啊啊、

查看全部 -

你男朋友查看全部

-

https://www.cnblogs.com/xiao-a啪啪le36/p/8433400.html

查看全部 -

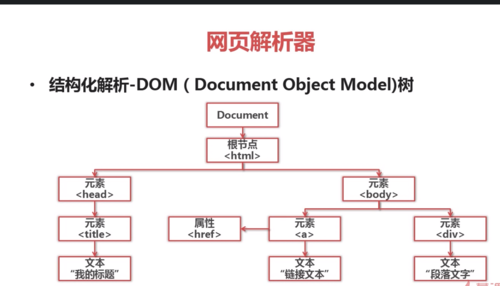

网页解析器

结构化解析-DOM

查看全部

查看全部 -

python爬虫实例代码演示

查看全部

查看全部 -

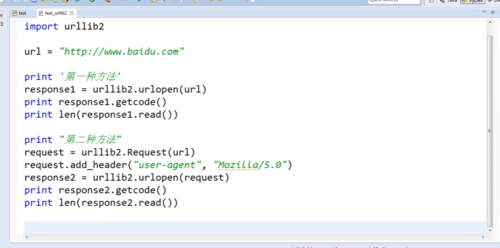

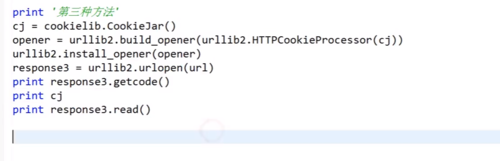

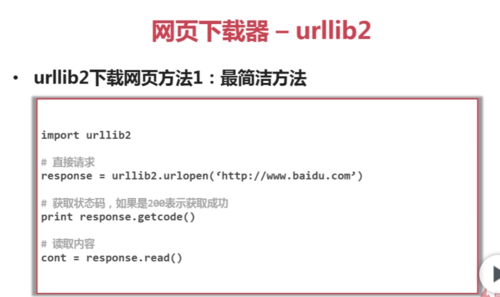

该下载器有以下三种下载方法:

①最简洁的方法:给定一个URL,将其传送给urllib2的urlopen方法,就可以实现。对应代码如下:

②添加http header向服务器提交http的头信息,添加data可以向服务器提交需要用户输入的数据,

我们生成三个参数,将其传送给request类,生成一个request对象,再用urllib2的urlopen方法以request为参数,发送网页请求。

③添加特殊情景的处理器:

例:有的网页需要用户登录才能访问,我们就需要添加cookie的处理,我们使用HTTPCookieProcessor;有的网页需要代理才能访问,我们使用ProxyHandle;有的网页的协议是HTTPS加密访问的,我们使用HTTPSHandler;有的网页的URL是相互自动的跳转,我们使用HTTPRedirectHandler。

将这些handler传送给urllib2的bulid_opener方法来创建对象,我们给urllib2再install这个opener,这样这个urllib2就具有了处理这些场景的能力,然后依然并用urlopen方法来请求一个URL,或请求一个request实现网页的下载。

查看全部 -

最简洁方法

查看全部

查看全部 -

折腾了几个小时,乱码问题终于解决了

UnicodeEncodeError: 'gbk' codec can't encode character ‘xxx’类似这种异常,因为在从网页上下载的页面是utf-8编码,默认情况下向硬盘中写入是用gbk编码,即要用 gbk 将 utf8 编码 转换为gbk编码。

我们知道utf8可以保存所有的字符,gbk作为中文编码肯定有些字符识别不了,此时只要在打开文件时指定编码:

fout = open("d:/xxx.html", 'a', encoding='utf-8')完美解决!

查看全部

举报