-

urllib2下载网页方法1的对应代码

导入urllib2模块

直接请求:调用urllib2的urlopen()方法给定一个字符串来实现网页的下载,返回内容传给response对象

获取状态码:调用response对象的getcode()方法,根据状态码是不是200来判断是不是获取成功

同时可使用response的read()方法来读取下载好的内容

查看全部 -

urllib2下载网页方法1

查看全部 -

py的2种网页下载器

查看全部 -

网页下载器

查看全部 -

URL的3种实现方式

查看全部 -

URL管理器

查看全部 -

简单的爬虫架构-运行流程

查看全部 -

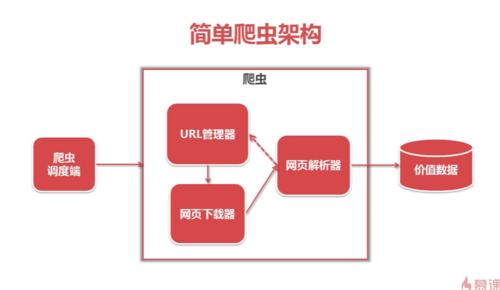

简单的爬虫架构:

首先需要一个爬虫调度端(启动爬虫,监视爬虫的运行情况),在爬虫程序中有三个模块,首先,URL管理器来对将要爬取的URL和已经爬取过的URL这两个数据的管理,从 URL管理器 取出待爬取的URL,将其传送给 网页下载器 ,下载器会将网页指定的URL下载下来,储存成一个字符串,这个字符串会传送给 网页解析器 进行解析,一方面会解析出有价值的数据,另一方面,每个网页都会解析出指向其他网页的URL,这些URL被解析出来之后,可以补充进URL管理器,URL管理器,网页下载器,网页解析器就形成一个循环,只要有相关的URL,就会一直运行下去

查看全部 -

http://www.crummy.com/software/BeautifulSoup/

Beautiful Soup下载

查看全部 -

好查看全部

-

第五章,需要多次看

查看全部 -

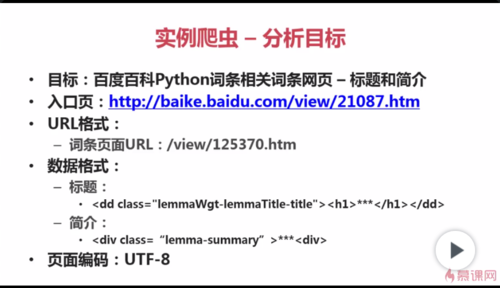

举例来说:见下图

查看全部

查看全部 -

分析目标:URL格式 数据格式 网页编码

查看全部 -

课程目标:是轻量级爬虫(不需要登录的静态网页抓取)

内容:爬虫架构(包含什么模块,以及模块是怎样组装在一起的)

查看全部 -

启动,停止,监视爬虫的运行情况--->爬虫调度端

查看全部

查看全部

举报