-

urllib2下载网页方法2:

导入urllib2模块

创建request对象:使用urllib2的request()方法,以url为参数,生成一个request对象

添加数据:使用request的add_data()方法,向服务器提交用户数据(如提交 a 这个数据项,它的值为1)

添加http的header:使用request的add_header()方法,向服务器提交头数据(如把爬虫伪装成浏览器)

发送请求获取信息:使用urllib2的urlopen()方法,以request为参数,来提交网页下载请求

查看全部 -

urllib2下载网页方法2:添加data、HTTP header

查看全部 -

urllib2下载网页方法1:最简单的方法

导入urllib2模块

直接请求:调用urllib2的urlopen()方法给定一个字符串来实现网页的下载,返回内容传给response对象

获取状态码:调用response对象的getcode()方法,根据状态码是不是200来判断是不是获取成功

读取内容:调用response对象的read()方法,读取下载好的内容

查看全部 -

网页下载器类型

urllib2--python官方基础模块

支持直接的url下载,或者用户输入基础数据

支持需要登录网页的cookie处理

支持代理访问的代理处理

requests--第三方包

查看全部 -

网页下载器工作流程

查看全部 -

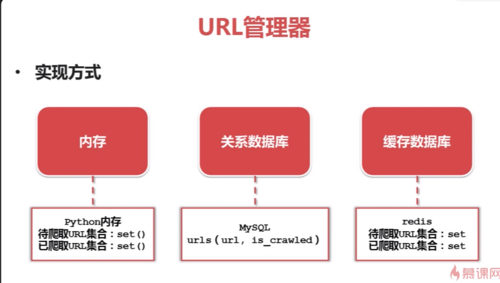

URL管理器实现方式

内存:set()方法可以去除重复数据 小公司存储

关系型数据库:可以永久存储

缓存数据库:dedis 大公司存储

查看全部 -

URL管理器

查看全部 -

简单爬虫架构-运行流程

查看全部 -

Python实例爬虫截图

查看全部 -

使用python3

1、

from urllib import request as urllib2

import http.cookiejar

2、

所有的print语句后需要加()

3、

cj=http.cookiejar.CookieJar()查看全部 -

Python爬虫,运行流程

查看全部 -

标记一下,爬虫架构

查看全部 -

爬虫的作用:

做新闻聚合阅读器

做爆笑故事app

采集美女图片网

数据对比网:图片价格比

技术文章大全

查看全部 -

from urllib import request from http import cookiejar url = 'http://www.baidu.com' print ("第一种方法") response1 = request.urlopen(url) resp1 = response1.read() print(response1.getcode()) print(len(resp1)) #print(resp1) print("第二种方法") request2 = request.Request(url) request2.add_header("user-agent", "Mozilla/5.0") response2 = request.urlopen(request2) respl2 = response2.read() print(response2.getcode()) print(len(respl2)) #print(respl2) print("第三种方法") cj = cookiejar.CookieJar() opener = request.build_opener(request.HTTPCookieProcessor(cj)) request.install_opener(opener) response3 = request.urlopen(url) print(response3.getcode()) print(cj) print(response3.read())查看全部 -

python的set自带防重复

查看全部

举报