-

Python3字符串默认使用Unicode编码,所以Python3支持多语言。

以Unicode表示的str通过encode()方法可以编码为指定的bytes。

如果bytes使用ASCII编码,遇到ASCII码表没有的字符会以\x##表示,此时只用'\x##'.decode('utf-8')就可以了

查看全部 -

发送POST请求

查看全部 -

携带header

查看全部 -

mark查看全部

-

from urllib import request resp = request.urlopen("http://www.baidu.com") print(resp.read().decode("utf-8"))查看全部 -

urllib库

查看全部 -

截图啊啊啊

查看全部

查看全部 -

输出某个页面的全部href

专业人士如何改代码,代码不是抄出来的,是改出来的

查看全部 -

课程 介绍

查看全部 -

beautiful soup

www.crummy.com/software/BeautifulSoup/#Download

查找修改树形结构,提供一些工具,可以解析文档

默认Unicode,utf-8

支持lxml和html5lib解析器

查看全部 -

爬虫注意事项查看全部

-

乱码的原因

查看全部 -

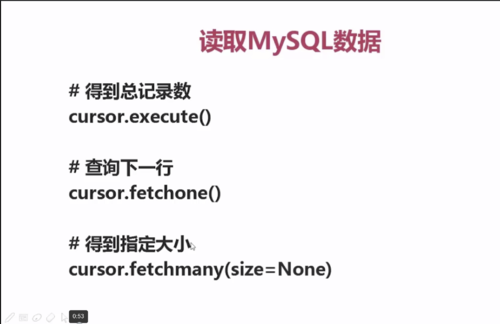

查询数据mysql

查看全部 -

https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/#id4

查看全部 -

# 爬出台湾高铁网站 from urllib.request import urlopen from urllib.request import Request from urllib import parse req = Request('http://www.thsrc.com.tw/tw/TimeTable/SearchResult') postData = parse.urlencode([ ('StartStation', '2f940836-cedc-41ef-8e28-c2336ac8fe68'), ('EndStation', '977abb69-413a-4ccf-a109-0272c24fd490'), ('SearchDate', '2018/06/25'), ('SearchTime', '23:30'), ('SearchWay', 'DepartureInMandarin') ]) req.add_header('Origin', 'http://www.thsrc.com.tw') req.add_header('User-Agent', 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36') response = urlopen(req, data=postData.encode('utf-8')) print(response.read().decode('utf-8'))查看全部

举报

0/150

提交

取消