-

检查是否安装成功

查看全部 -

检验python及其他是否安装成功

查看全部 -

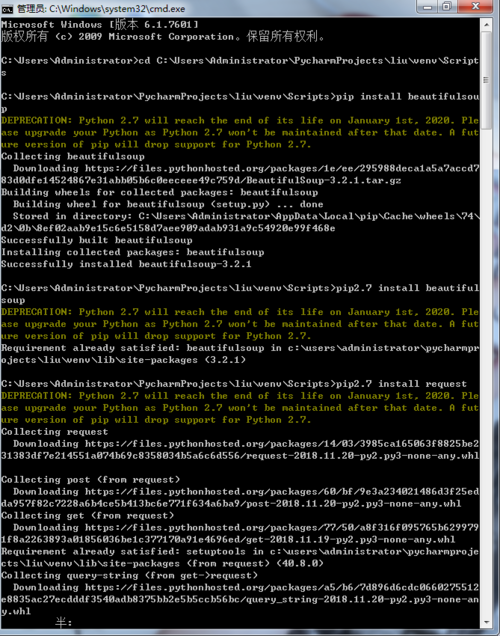

安装完python后,再安装beautifulsoup4

查看全部 -

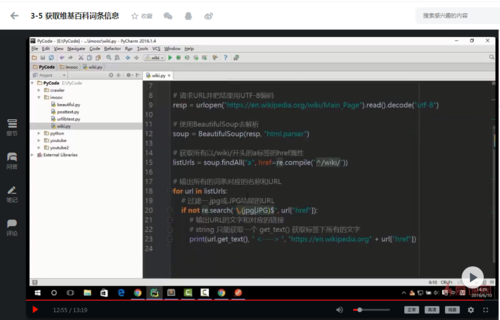

from url.requst import urlopen

from bs4 import BeautifulSoup

import re

#获取网页源代码

resp= urlopen("https://en.wikipedia.org/wiki/Main_Page").read().decode("utf-8")

#解析?网页

soup = BeautifulSoup(resp."html.parse")

#获取所有以/wiki/开头的链接

urls = soup.findAll('a',href=re.compeil("^/wiki/"))

#获取链接内容

for uls in urls:

if not re.search("/.(jpg|JPG)$",url["href"])

print(url.get_text(),url["href"])

查看全部

查看全部 -

soup = bs(html_doc,"html.parse")

print(soup.title.string)#当title不止一个时会报错

print(soup.title.get_text())

print(soup.a)

print(soup.find(id="link2").get_text)

print(soup.find(id="link2").string)

#print(soup.findAll("a").string)

for link in soup.findAll("a"):

print(link.string)print(soup.find("p",{"class":"story"}))

查看全部 -

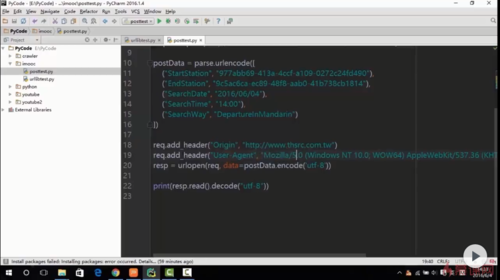

post(异步加载的应用):表单的内容记一下和有两个请求头(来源和头)

查看全部

查看全部 -

post是应用在响应对象中(即要求你下指令之后网页响应的信息)

谷歌内可以使用postman进行查看你想要响应的对象内容是什么

查看全部 -

反爬虫还有一个:origin

查看全部 -

携带请求头的爬虫是最简单的反爬虫的方法:

rep = requst.Requst(url)

rep.add_header(key,value)

resp = request.urlopen(req)

print(resp.read().decode("utf-8")

查看全部 -

读取文件方式

查看全部 -

Python安装pip

查看全部

查看全部 -

使用post2

查看全部 -

使用post1

查看全部 -

模拟浏览器访问

查看全部 -

urllib

查看全部

举报