-

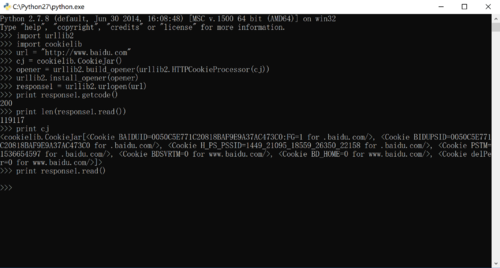

获取爬取状态码,并获取爬取网页数据

查看全部 -

存一下查看全部

-

方法3结果

查看全部 -

网页解析器dom

查看全部 -

网页解析器

查看全部 -

import urllib2,cookielib

#创建cookie容器

cj = cookielib.CookieJar()

#创建1个opener

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cj))

#给urllib2安装opener

urllib2.install_opener(opener)

#使用带有cookie的urllib2访问网页

response= urllib2.urlopen('http://www.baidu.com)

查看全部 -

import urllib2

#创建Request对象

request = urllib2.Request(url)

#添加数据

request.add_data('a','1')

#添加HTTP的header

request.add_header('User-Agent','Mozilla/5.0')

#发送请求获取结果

response = urllib2.urlopen(request)

查看全部 -

import urllib2

#直接请求

response = urllib2.urlopen('http://www.baidu.com')

#获取状态码,如果是200表示获取成功

print response.getcode()

#读取内容

cont = response.read()

查看全部 -

爬虫流程图

查看全部 -

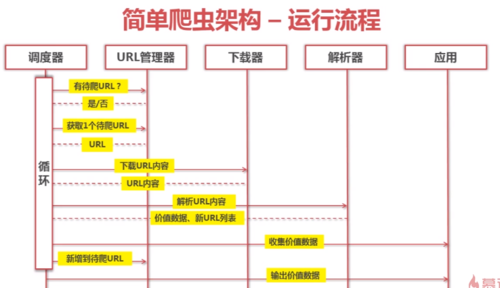

简单爬虫架构运行流程:

查看全部

查看全部 -

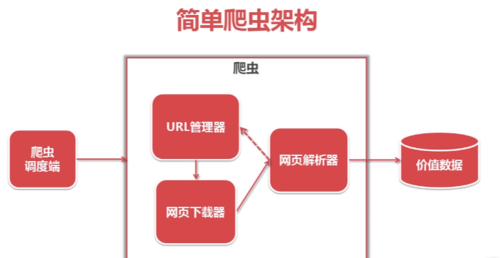

简单爬虫架构

查看全部

查看全部 -

爬虫:自动访问互联网(url)并且提取数据的程序。

查看全部 -

解析器里面的 page_url 是什么意思? 怎么没有定义呢

查看全部 -

from urllib import request rsep=request.urlopen(' html_data=resp.read().decode('utf-8') print(html_data)查看全部 -

爬虫:一段自动从互联网抓取信息的程序

查看全部

举报