爬了一个,第二个failed就停止了

张小飞0

2016-06-01

5 回答

我用着不是太好治疗癫痫病的方法

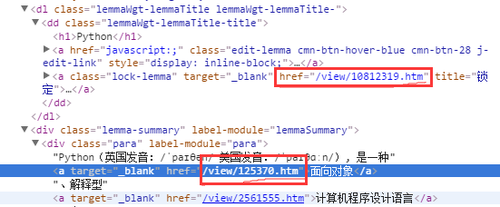

你点击第二的url会发现他是锁定词条的页面,去看html代码的话可以看出来“锁定”这个href的模式也是/view/123.htm,所以按照视频里的代码第一条抓出来的就是锁定,这个会出现错误。

比较笨的方法,我在parser里面加入了个判断:

for link in links: new_url = link['href'] new_full_url = urlparse.urljoin(page_url, new_url) # print new_full_url if new_full_url == 'http://baike.baidu.com/view/10812319.htm': continue new_urls.add(new_full_url) return new_urls

这样就可以了

举报

0/150

提交

取消