-

sigmoid是非对称的

查看全部 -

激励函数的作用是提供规模化的非线性化能力

查看全部 -

逻辑回归是一种最简化的网络结构。

查看全部 -

结构性的顺序

结点和层的概念

解决的是非线性问题,这个体现在每个神经元的设计上。包括隐含层和输出层。

神经元的操作:把输入进来的东西进行组合,然后进行一个非线性的处理

查看全部 -

网络结构

激励函数

损失函数

梯度下降

查看全部 -

主要功能:分类识别

分类:图像、语音、文本

查看全部 -

神经网络

起源:20世纪中叶,实际上是一种仿生学产品。目标是像人脑一样思考。

兴起:

环境:二进制创新

能力:软硬件

需求:人的性价比

查看全部 -

激励函数是对大脑中传递介质的模拟,非线性的变化

Sigmoid tanh ReLU

2.1sigmoid (0-1)优势:整个函数可导,后期反向传播

缺点:对称点:0.50(数据中心化)-》tanh

趋向比较小或比较大时,变化平缓

2.2ReLU

查看全部 -

结构性顺序

从输入到隐含层到输出再到最后得到预测结果

深度(层)比宽度(节点),一层一层分析,从色彩到线到形状

神经网络解决的问题是非线性的(体现在隐含层和输出层)

神经元两部分:线性组合和非线性的处理

查看全部 -

1.神经网络主要功能:分类识别,通过函数

2.图像,语音,文本

2.1图像和语音是密集型矩阵(非零值),文本是稀疏性矩阵(零值居多,预处理工作)

2.2基础应用:

图像-》自动驾驶,语音-》语音助手,文本-》新闻推送

查看全部 -

神经网络

网络结构

激励函数

损失函数

梯度下降

查看全部 -

主要功能:分类识别(图像、语音、文本)

查看全部 -

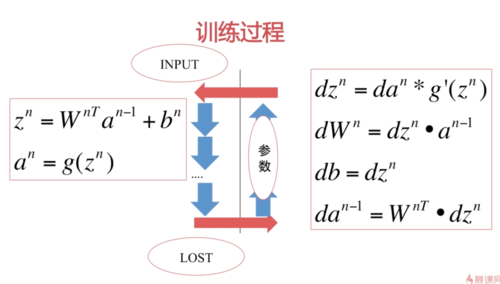

迭代,调整参数

查看全部

查看全部 -

图像和音频是密集型 文本是稀疏型查看全部

-

1:激励函数 :2损失函数 3:梯度下降

查看全部

举报