-

Logstash-Filter配置

查看全部 -

Logstash的输入和输出配置

查看全部 -

处理流程

input:可以从file 、Redis 、beats、kafka等读取数据

filter :gork(表达式,简单理解为基于正则的,可以将非格式化数据转化成格式化数据的语法)、mutate(可以对结构化的数据的字段进行增删改查)、drop、date

output :可以向stdout 、elasticsearch 、Redis、kafka等中输出

查看全部 -

简介 data shipper (不是轻量级的,会比beats占用更多的资源,但是功能强大)

ETL的概念:Extract 对数据进行提取、Transform 转换、Load 对外的输出

logstash 是一个开源的,服务端的数据处理流,可以同时从多个数据源提取数据、转换数据、最后把数据放到你要存储的地方

查看全部 -

packetbeat

查看全部 -

Packbeat运行命令

查看全部 -

packetbeat.interfaces.device: 指定网卡,lo0:表示是本地网卡localhost,在linux上,你可以指定为any,表示所有的

packetbeat.protocols.http: 表示抓取http协议包

send_request:true 表示记录下http的request内容,默认为false

include_body_for: 设置抓取的格式

output.console:

pretty: true beat的输出配置

查看全部 -

Packetbeat简介

查看全部 -

使用Filebeat存储nginx日志:

1.修改filebeat的配置,nginx.yml,修改内容如下:

- input_tyep: stdin output.console: pretty: true

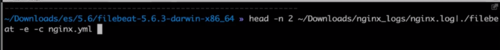

2.使用Filebeat收集nginx日志,命令:

head -n 2 ~/Downloads/nginx_logs/nginx.log|./filebeat -e -c nginx.yml

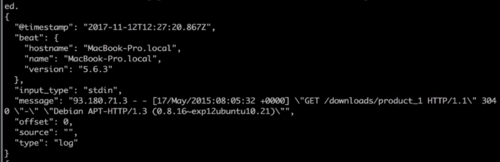

3.执行后效果

查看全部

查看全部 -

Filebeat Module

对于社区常见需求进行配置封装增加易用性 :

例如 Nginx 、Apache 、 MySQL 的日志

封装内容:

filebeat.yml配置、ingest node pipeline 配置、kibana dashboard

查看全部 -

Filebeat +Elasticserch Ingest Node

查看全部 -

Filebeat Filter配置

查看全部 -

filebeat filter 的处理能力

input 时处理:

include_lines : 达到某些条件的时候,读入这一行

exclude_lines :达到某些条件的时候,不读入这一行

exclude_files:当文件名符合某些条件的时候,不读取这个文件

output 前处理 --Processor

drop_event :读取到某一条,满足了某个条件,不输出

drop_fields :读取到某一条,满足了某个条件,不输出这个字段

Decode_json_fields :把这条数据里面符合json格式的字段,去做json的解析

Include_fields :加入一些字段,或者是只想取数据里面的某一些字段

查看全部 -

Filebeat 输出配置

查看全部 -

Filebeat配置

查看全部

举报