-

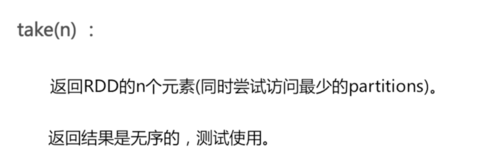

take(n):

随机取n个数

查看全部 -

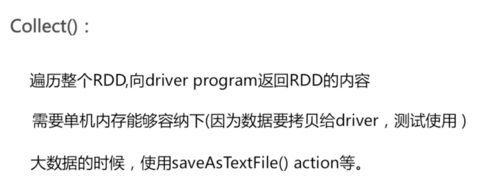

collect()

查看全部 -

:222222

查看全部 -

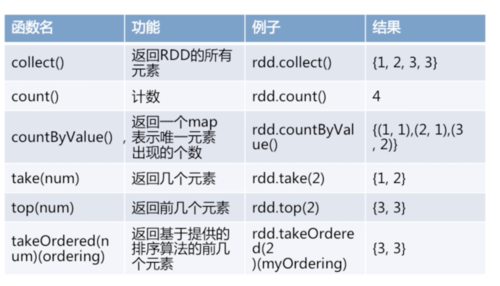

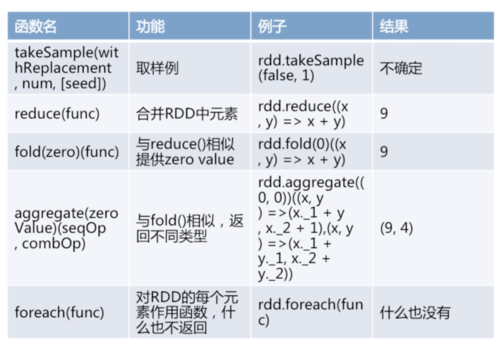

rdd action:

查看全部 -

后续课程:

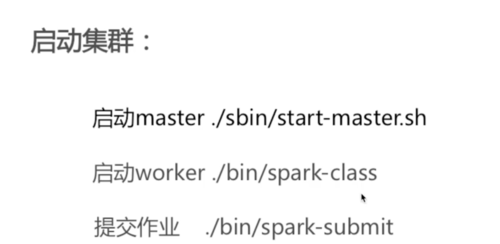

Spark架构

Spark运行过程

Spark程序部署

查看全部 -

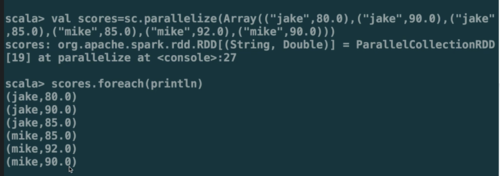

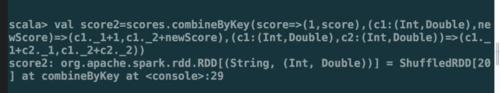

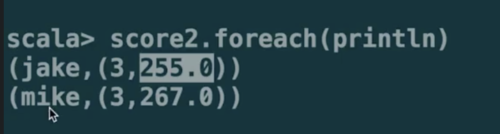

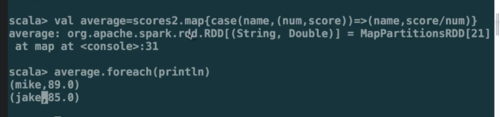

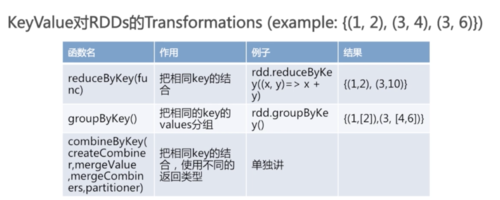

combineByKey():

(createCombiner, mergeValue, mergeCombiners, partitioner)

最常用的基于key的聚合函数,返回的类型可以与输入类型不一样。

许多基于key的聚合函数都用到了它,像groupByKey()

遍历partition中的元素,元素的key,要么之前见过的,要么不是。

如果是新元素,使用我们提供的createCombiner()函数

如果是这个partition中已经存在的key,就会使用mergeValue()函数

合并每个partition的结果的时候,使用mergeCombiners()函数

查看全部

查看全部 -

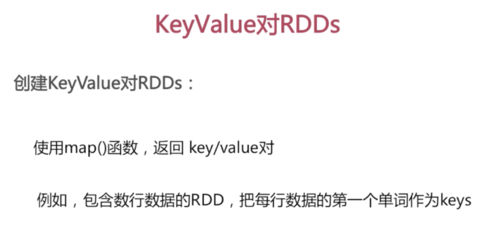

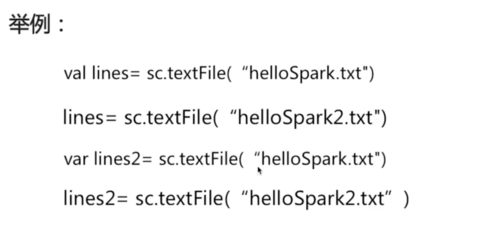

val rdd2 = rdd.map(line=>(line.split(" ")(0), line))

查看全部

查看全部 -

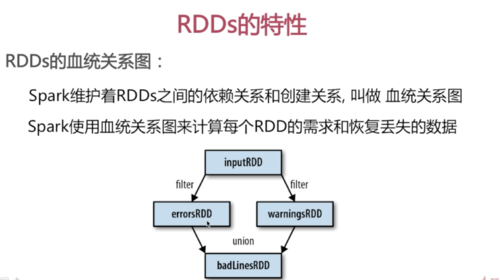

RDDs的血统关系图

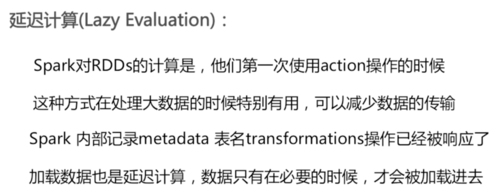

延迟计算

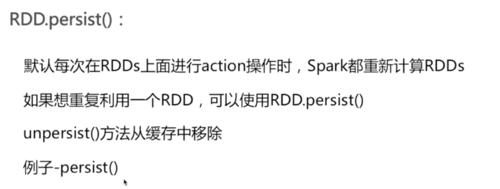

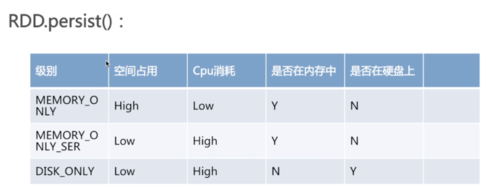

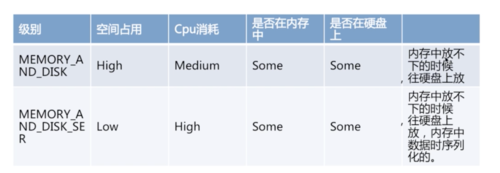

RDD.persist()

查看全部 -

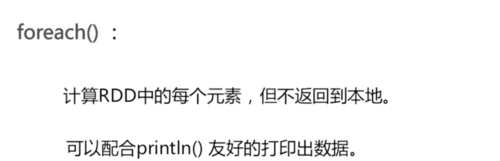

Action介绍:

在RDD上计算出来一个结果。

把结果返回给driver program或保存在文件系统,count(),save

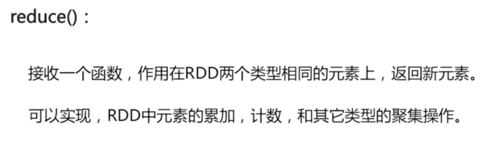

rdd.reduce((x,y)=>x+y)

查看全部

查看全部 -

集合运算

RDDs支持数学集合的计算,例如并集、交集等

val rdd_distinct = rdd1.distinct()

val rdd_union = rdd1.union(rdd2)

val rdd_inter = rdd1.intersection(rdd2)

val rdd_sub = rdd1.subtract(rdd2)

查看全部 -

Transformations介绍:

Transformations(转换)

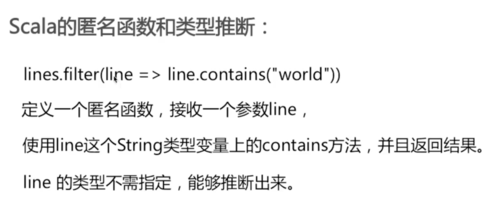

从之前的RDD构建一个新的RDD,像map()和filter()

逐元素Transformations:

map()接收函数,把函数应用到RDD的每一个元素,返回新RDD

filter()接收函数,返回只包含满足filter()函数的元素的新RDD

flatMap(),对每个输入元素,输出多个输出元素。flat压扁的意思,将RDD中元素压扁后返回一个新的RDD

val lines = inputs.flatMap(line=>line.split(" "))

lines.foreach(println)

查看全部 -

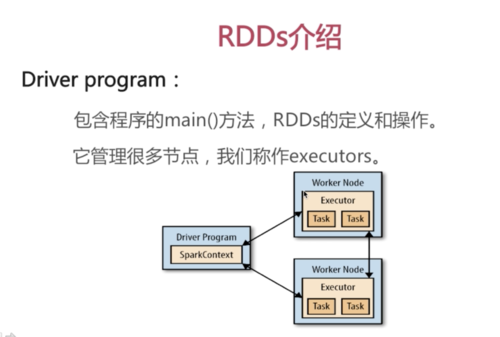

Driver Program

SparkContext

RDDs

查看全部 -

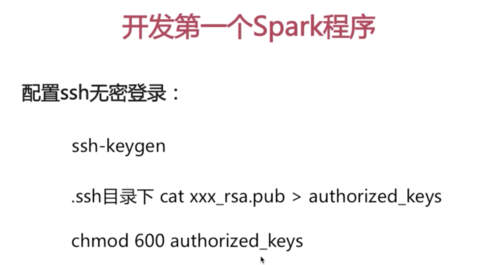

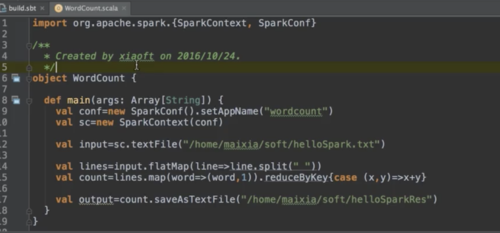

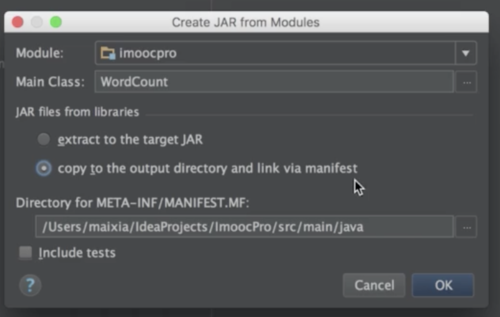

WordCount程序开发

查看全部 -

默认安装选项会自动配置环境变量。

Spark 1.6.2 -- Scala 2.10

Spark 2.0.0 -- Scala 2.11

IntelliJ IDEA常用的设置:

主题和颜色

编辑器界面字体设置

光标所在行背景颜色

查看全部 -

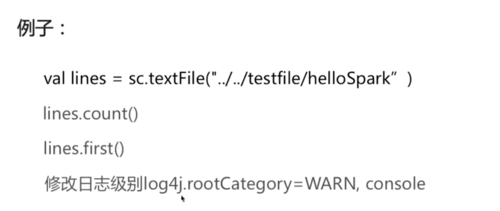

Spark下载,安装;

Spark Shell操作

查看全部

查看全部

举报