-

查看全部

查看全部 -

查看全部

查看全部 -

查看全部

查看全部 -

查看全部

查看全部 -

查看全部

查看全部 -

查看全部

查看全部 -

1

查看全部 -

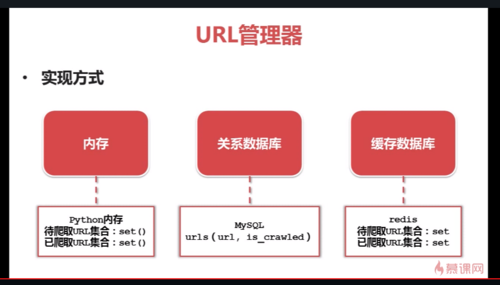

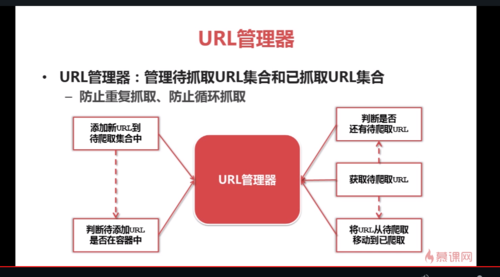

用is_crawled来表示待爬取还是已爬取

查看全部 -

大型公司使用缓存数据库

小型公司或个人使用内存

内存不够用或想要永久存储 使用关系数据库

查看全部 -

Python中,数值类型(

int和float)、字符串str、元组tuple都是不可变类型。而列表list、字典dict、集合set是可变类型。查看全部 -

视频很不错。按照视频的代码,查看多线程库,threading, Queue, 搞了一个多线程的版本,https://github.com/dengshilong/baike_spider/blob/master/spider_thread.py

python3爬虫实例源码 https://github.com/fifths/python_baike_spider.git

查看全部 -

现在百度的是https加密方式的了,而且目录结构也变了,所以写的时候要改一下

比如使用Request对象

response = urllib2.urlopen(request,context = context)

页面解析的话可以

links = soup.findAll('a',href=re.compile(r"/item/"))

这样子就能匹配到了查看全部 -

第二条就没有了的朋友,是因为百度改规则了,你们老是去爬。

html_parser 找到这里,改成: links = soup.find_all('a', href=re.compile(r"/item/.*"))

就可以了。查看全部 -

出现一条记录,第二条就failed的原因是

links = soup.find_all('a', href=re.compile(r'/view/\d+\.htm'))

百度百科修改了页面

咱们只需修改爬取规则 把view改成item 再把/\d+\.htm 去掉就能匹配新的url了查看全部 -

Python3

html页面出现乱码,解决方法:

1)打开文件时加上编码:

fout = open('output.html', 'w', encoding='utf-8')

2)视频中在写入标题和内容时加入了编码转换,去掉,不要加,直接这样写:

fout.write("<td>%s</td>" % data['title'])查看全部

举报