-

Beautifulsoup网页解析器 html_content = Beautifulsoup(,解析器,编码格式) find_all( name, attribute, string) find 支持正则表达式 re.compile查看全部

-

访问节点信息

查看全部 -

搜索节点(find_all,find)

查看全部 -

# -*-coding:utf-8 -*- from bs4 import BeautifulSoup # 根据HTML网页字符串创建BeautifulSoup对象 soup = BeautifulSoup( html_doc, #HTML文档字符串 'html.parser', #HTML解析器 from_encoding ='utf-8' #HTML文档的编码 ) # 方法:find_all(name,attrs,string) # 查找所有标签为a的节点 soup.find_all('a') # 查找所有标签为a,链接符合/view/123.htm形式的节点 soup.find_all('a',href='/view/123.htm') soup.find_all('a',href=re.compile(r'/view/\d+\.htm')) # 查找所有标签为div,class为abc,文字为Python的节点 soup.find_all('div',class_='abc',string="Python")查看全部 -

import urllib2 #直接请求 response=urllib2.urlopen('http://www.baidu.com') #获取状态码,如果是200表示获取成功 print response.getcode() #获取内容 cont=response.read()查看全部 -

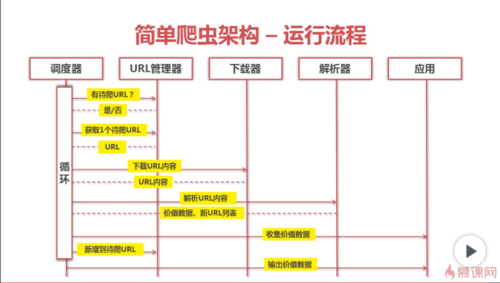

Python简单爬虫架构运行流程查看全部

Python简单爬虫架构运行流程查看全部 -

爬虫查看全部

-

网页解析器查看全部

-

url管理器实现方式查看全部

-

缓存数据库 redis

查看全部 -

urllib2下载网页方法1

查看全部 -

简单爬虫架构运行流程

查看全部 -

牛逼了1查看全部

-

爬虫价值:爬去互联网数据并存储下来后,可以对有价值数据进行更方便的分析、学习、利用,甚至可以基于这些数据制作出相应的产品如APP等。

查看全部 -

简单爬虫架构 — 运行流程

查看全部

举报

0/150

提交

取消