-

使用代理IP地址来爬取目标网站的数据,防止被发现之后封禁真实IP

# user agent 列表

USER_AGENT_LIST = [

'MSIE (MSIE 6.0; X11; Linux; i686) Opera 7.23',

'Opera/9.20 (Macintosh; Intel Mac OS X; U; en)',

'Opera/9.0 (Macintosh; PPC Mac OS X; U; en)',

'iTunes/9.0.3 (Macintosh; U; Intel Mac OS X 10_6_2; en-ca)',

'Mozilla/4.76 [en_jp] (X11; U; SunOS 5.8 sun4u)',

'iTunes/4.2 (Macintosh; U; PPC Mac OS X 10.2)',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:5.0) Gecko/20100101 Firefox/5.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:9.0) Gecko/20100101 Firefox/9.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.8; rv:16.0) Gecko/20120813 Firefox/16.0',

'Mozilla/4.77 [en] (X11; I; IRIX;64 6.5 IP30)',

'Mozilla/4.8 [en] (X11; U; SunOS; 5.7 sun4u)'

]

查看全部 -

scrapy 架构图

查看全部 -

scrapy 安装 : pip install scrapy

https 网站不能访问

解决: yum install -y openssl-devel

然后重新编译python

查看全部 -

分布式爬虫,应对反爬策略

查看全部 -

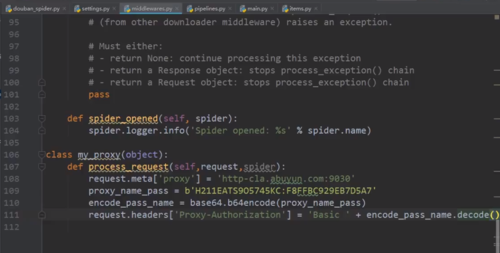

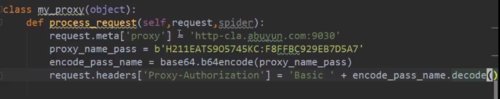

使用ip代理

查看全部

查看全部 -

linux 一些基本能力,scrapy,mongodb安装及简单的设置

scrapy框架,组件,数据流

scrapy实战

查看全部 -

l = len(content) for i in range(l): for j in range(i+1,l): content_s = "".join(content[i].split())+" "+"".join(content[j].split()) douban_item['introduce'] = content_s print(douban_item)

现在豆瓣还追加了导演会导致每个类有两行

我的代码可以让它们合并为一行

查看全部 -

编写itemPipeline保存数据

查看全部 -

注意事项!

查看全部 -

随机产生user_agent

查看全部 -

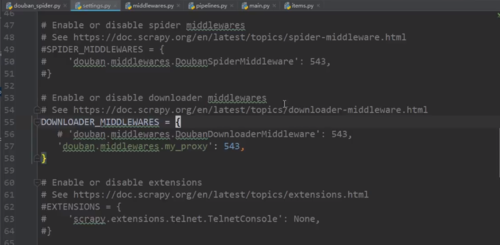

在设置中打开下载中间件

查看全部 -

记得在setting中开启pipeline选项

查看全部 -

导出数据

scrapy crawl douban_spider -o test.json

查看全部 -

运行爬虫

在spider文件夹中

scrapy crawl douban_spider

查看全部 -

生成爬虫

在spiders目录下

scrapy genspider douban_spider 域名

查看全部

举报