作为开发者,我们总是在寻找能够提升我们的工作流程、加快项目进度并突破技术极限的 AI 突破。微软最新的 Phi 系列语言模型 Phi-4 已经问世。Phi-4 在自然语言处理(NLP)和多模态能力方面取得了显著进展,引起了广泛关注,这绝非徒有虚名。在这篇文章中,我们将深入探讨 Phi-4 的功能、性能基准,以及它为何对开发者来说是一场变革,尤其是那些与 API 打交道的开发者。

φ-4是什么?Phi-4 是微软研究院开发的 Phi 系列的第四款,通过引入新的架构创新和技术训练,提升了其速度、准确性和灵活性,使其更加高效。Phi-4 的独特之处在于它有两种版本:Phi-4 Mini 和 Phi-4 多模态。每个版本针对特定应用场景,提供定制化的功能。

Phi-4本质上是一个基于变压器的模型,设计用来处理各种NLP任务,从文本生成和总结到代码补全和问答。尤为令人印象深刻的是,Phi-4在保持顶级性能的同时更加紧凑,使其在资源受限的环境中更易于部署。

虽然 Phi-4 正在推动人工智能的边界,Apidog 在 API 开发方面也正在取得进展。如果你厌倦了管理多个工具来设计、测试和记录 API,Apidog 正是你一直在寻找的一站式解决方案。它正迅速成为 Postman 的一个受欢迎的替代品,提供了一个统一的平台,让您的 API 开发流程更简单。

Phi-4 Mini 是 Phi-4 的轻量版,专为需要高性能的人工智能而无需处理大型模型计算负担的开发人员和组织打造。它非常适合文本任务,例如:

- 文本生成

- 摘要生成

- 代码补全

- 问答系统

Phi-4 多模态版 相比之下则是加强版本。它专门用于处理需要跨文本、图像和音频等多种类型数据进行推理的复杂多模态任务。其主要应用包括:

- 图像问答

- 文档解析

- 语音识别和翻译

- 图表和表格理解

- 高效架构

Phi-4 引入了一种稀疏注意力机制,大幅降低了计算成本,同时保持性能不变。这使其非常适合文档总结和代码生成等任务。 - 多模态输入处理

Phi-4 能够处理不仅仅是文本,还有图像和音频,这为构建需要结合不同类型数据的应用程序打开了新的可能。 - 灵活的微调

通过像 LoRA(低秩适应)和提示微调这样的技术,Phi-4 允许开发人员无需重新训练整个系统即可针对特定任务调整模型,从而节省时间和计算资源。 - 开源和社区驱动

Phi-4 是一个开源项目的一部分,为开发人员提供了预训练模型、微调脚本和详尽的文档,以帮助他们快速上手。

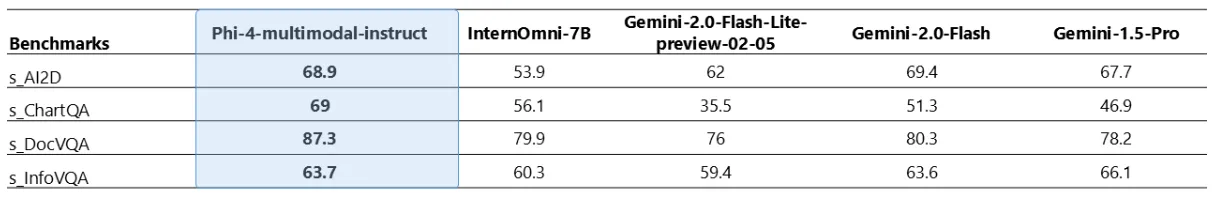

Phi-4 在 AI 领域设立了新的标准,特别是在涉及视觉、音频和文本输入的多模态任务方面。让我们来看看它在不同基准测试中的表现。

视觉效果和音效Phi-4 多模态模型在需要同时处理视觉和声音输入的任务中表现出色之处。下面我们快速看一下它的表现:

- SAi2D : Phi-4 得分 93.2,超过了 Gemini-2.0-Flash 的 91.2。

- SChartQA : Phi-4 得分 95.7,优于 Gemini-2.0-Flash-Lite 的 92.1。

- SDocVQA : Phi-4 得 82.6,超过了 Gemini-2.0-Flash 的 77.8。

- SInfoVQA : Phi-4 得 77.1,而 Gemini-2.0-Flash 获得 73 分。

这些分数说明了Phi-4在处理复杂多模态任务时的高精度表现。

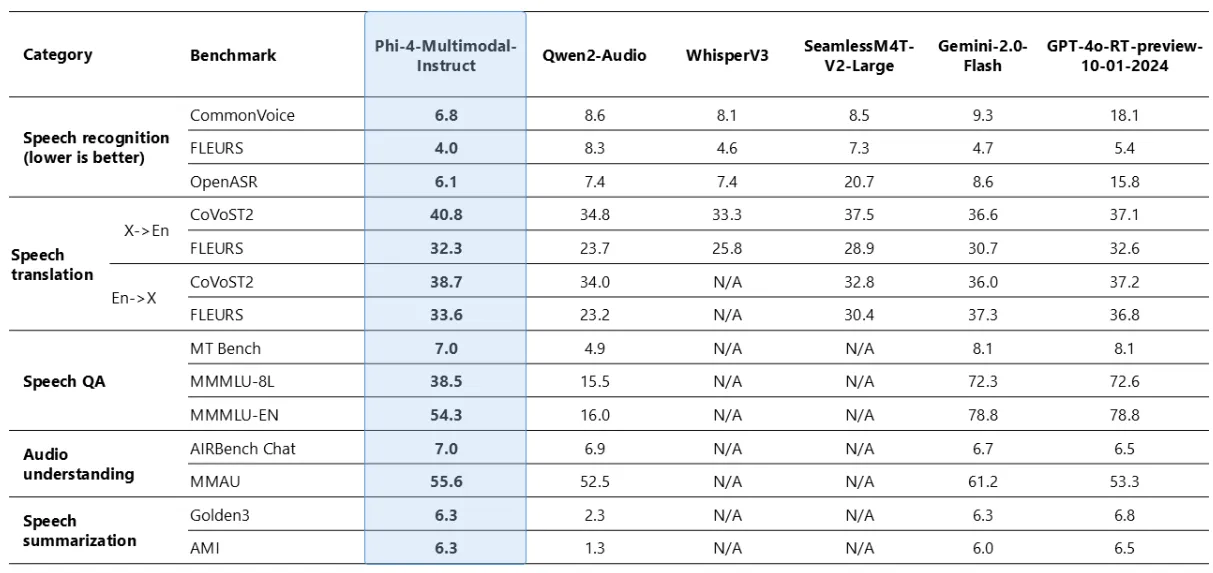

与演讲有关的任务Phi-4 在与语音相关的基准测试中也引起了很大的反响, 在这些任务上表现优于像 WhisperV3 和 SeamlessM4T-v2-Large 一样的模型。值得一提的是:

- OpenASR 排行榜:Phi-4 以 6.14% 的字错误率 (WER) 排名第一,优于之前的最佳成绩(6.5%)。

- 语音摘要:在性能上与 GPT-4o 不相上下,是少数几个成功完成此任务的开源模型之一,表现相当出色。

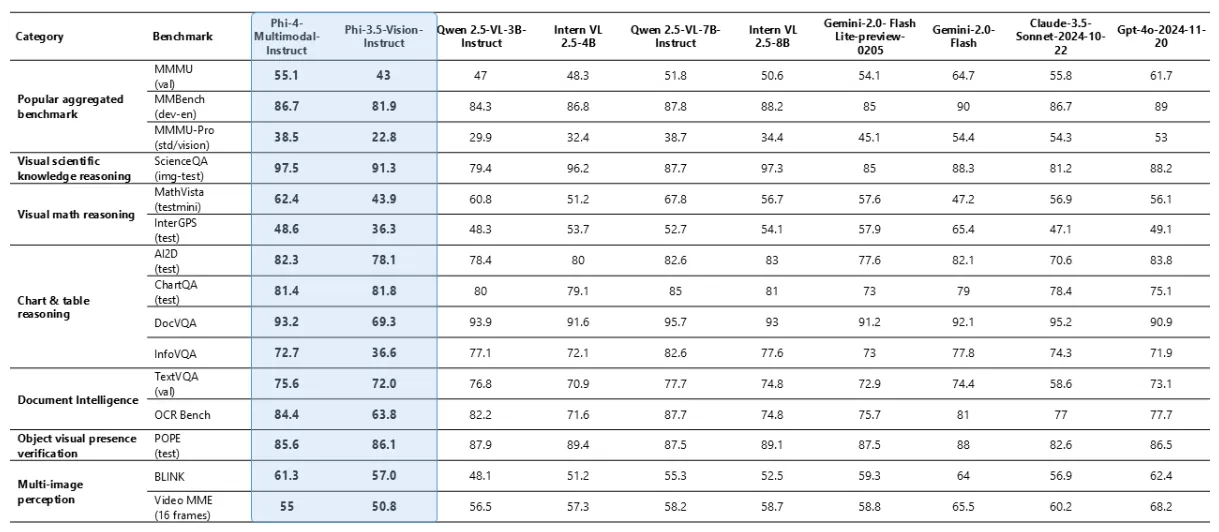

即使只有5.6亿参数,Phi-4在视觉任务方面也能表现出色。

- MMMU (val) :Phi-4 得分 55.1,超过了 Qwen 2.5-VL-7B-Instruct 和 Intern VL 2.5–8B。

- DocVQA ,在 93.2 分,与更大的模型比如 Gemini-2.0-Flash 和 Claude-3.5-Sonnet 直接较量。

尽管Phi-4体积小巧,它在视觉基准测试中依然表现出色,证明了小模型依然可以大显身手。

Phi-4不仅仅是一个普通的AI更新,而是在效率、多功能性和易用性方面实现了巨大的飞跃。

- 效率:其稀疏注意力机制减少了计算负担,使其更容易训练和部署,从而降低成本并减少对环境的影响。

- 多功能性:该模型的多模态功能为开发需要处理多种数据类型的开发者们提供了丰富的可能性。

- 可访问性:作为开源项目,开发者可以自由地实验、适应并将其集成到自己的系统中,而无需面对通常的障碍。

准备好开始使用NVIDIA API进行多模态任务了吗?这里有一份快速指南来帮助你开始。

- 安装所需的库:

首先,确保你安装了requests库。可以使用 pip 来安装。

pip install requests # 安装requests库2. 准备文件:

准备好一张图片(例如 image.png)和一个音频文件(例如 audio.wav),用于处理的准备。

3. 运行以下 Python 代码:

通过 NVIDIA 的 API 与 Phi-4 交互:

import requests

response = requests.post(

'https://api.nvidia.com/phi4',

headers={'Authorization': 'Bearer $API_KEY'},

files={'图像': open('image.png', 'rb'), '音频文件': open('audio.wav', 'rb')}

)

# 发送图像和音频文件到NVIDIA API

print(response.json())4. 解释结果:

程序将根据图像和音频输入返回见解,便于分析和直接集成到您的应用程序中。

Phi-4 正在为人工智能设立新的标准,提供涵盖自然语言处理、多模态和语音相关任务的顶尖性能。凭借其小巧的体积、高效和开源特性,Phi-4 是开发人员用于复杂现实世界实际应用的理想选择。

而且在你忙這件事的同時,別忘了查看Apidog——一個正在轉變API開發方式並提供比Postman更好的替代方案的工具。开发者现在拥有强大的工具来构建更智能、更快、更高效的系统。

共同学习,写下你的评论

评论加载中...

作者其他优质文章