DeepSeek的新型大模型推理

DeepSeek 提出了一种创新方法,通过强化学习(RL)来提升大型语言模型(LLM)的推理能力,该方法在他们最近发表的关于 DeepSeek-R1 的论文中详细说明。这项研究标志着我们可以通过纯粹的强化学习,而非依赖大量的监督微调,显著增强大型语言模型(LLM)解决复杂问题的能力,取得了重要突破。

在我们继续之前,如果你对这个话题感兴趣,并想支持我的话?

- 给我点个赞 我的文章10次;这真的会帮到我👏

- 关注我 在Medium,看我的最新文章 🫶

DeepSeek-R1技术概述

模型架构:

DeepSeek-R1 不只是一个单一的模型,而是一个模型家族,DeepSeek-R1-Zero 和 DeepSeek-R1 模型

让我来解释一下DeepSeek-R1和DeepSeek-R1-Zero这两个版本之间的主要不同点:

首要区别

DeepSeek-R1-Zero 代表团队最初的实验,使用纯粹的强化学习方法,没有经过任何监督微调的过程。他们从基础模型开始,直接应用强化学习,让模型通过试错发展推理能力。尽管这种方法取得了令人印象深刻的成果(AIME 2024上达到了71%的准确率),但它存在一些显著的局限性,特别是在可读性和语言一致性方面。该模型包含6710亿参数,采用专家混合(MoE)架构模型,每个标记激活的参数约为370亿。该模型展示了诸如自我验证、反思和长链思维推理(CoT)等涌现的推理能力。

DeepSeek-R1 相比之下,则采用了一种更复杂的多阶段训练流程。它不是纯粹的强化学习,而是先在一小部分精心挑选的样例(这些样例被称作“冷启动数据”)上进行监督微调,然后再应用强化学习。这种方法解决了 DeepSeek-R1-Zero 的问题,并且在性能上更胜一筹。该模型也保持了 6710 亿个参数,但在响应的易读性和一致性方面表现更佳。

训练过程的对比训练方法:

- 强化学习:与依赖监督学习的传统模型不同,DeepSeek-R1广泛使用了强化学习 (RL)。训练过程利用了群体相对策略优化 (GRPO),侧重于准确性和格式奖励,以提升推理能力,而无需大量的标注数据。

- 蒸馏技术:为了让更多人能访问高性能模型,DeepSeek还发布了R1的精简版本,参数量从15亿到700亿参数不等。这些模型基于Qwen和Llama等架构,表明复杂的推理能力可以被压缩到更小、更高效的模型中。蒸馏过程涉及使用由全量DeepSeek-R1生成的合成推理数据对这些较小模型进行微调,从而在减少计算成本的同时保持高性能。

DeepSeek-R1-Zero的训练过程十分简单:

- 从基本模型开始

- 直接使用强化学习

- 简单的奖励措施,基于准确性和格式

DeepSeek-R1的训练过程分为四个阶段。

- 初始的监督微调,基于数千个高质量样本

- 专注于推理任务的强化学习

- 通过拒绝采样来收集新训练数据

- 在所有类型任务上进行最终的强化学习

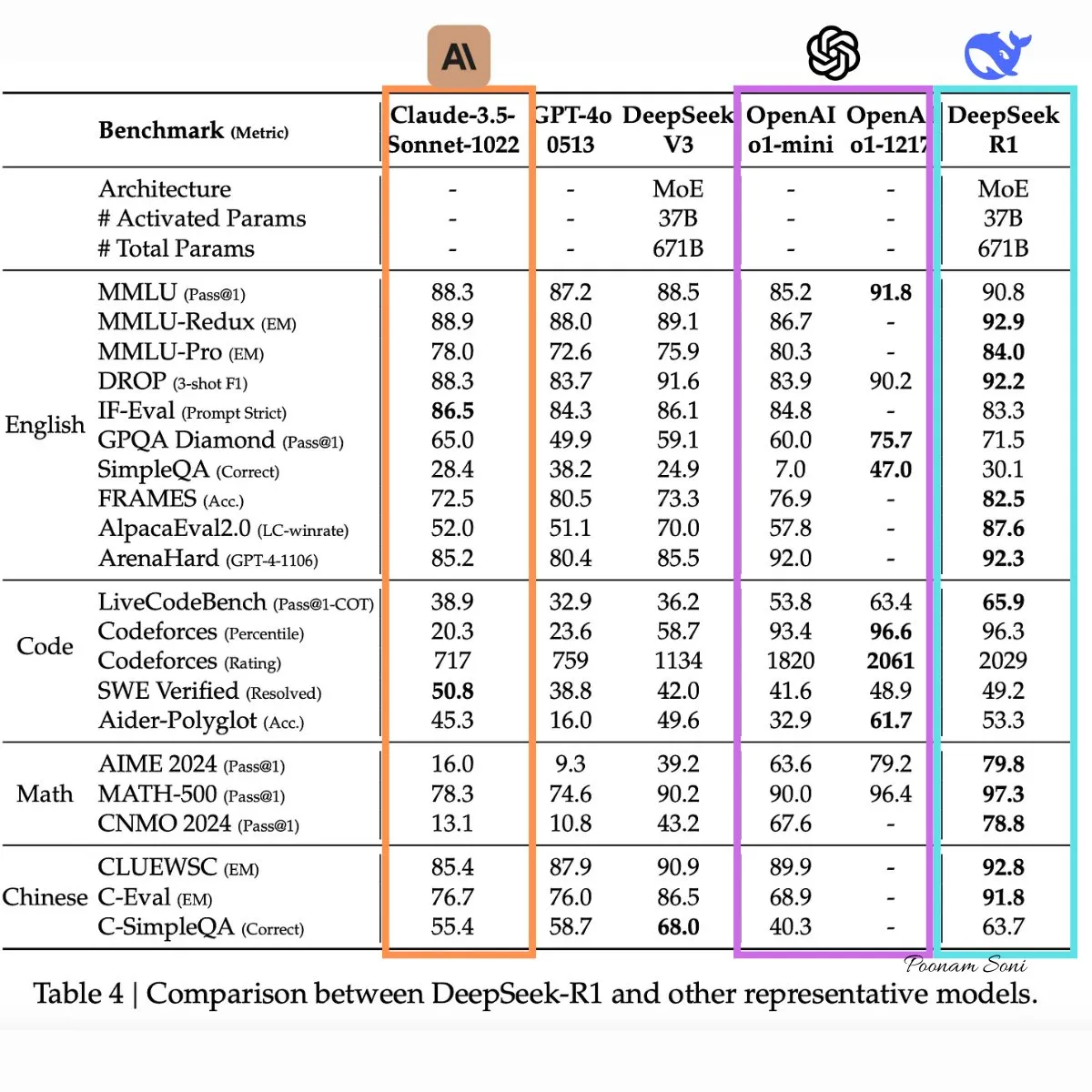

表现衡量标准:

- 推理测试:DeepSeek-R1 在多个基准测试中表现出色:

- 2024年AIME:通过率为 79.8%,比 OpenAI 的 o1–1217 高出 0.6%。

- MATH-500:得分 97.3%,比 OpenAI 的 o1–1217 高出了 0.9%。

- SWE-bench 验证:在编程任务中表现出色,证明了其编程能力。

- 成本效益比:DeepSeek-R1 的 API 每百万输入令牌缓存命中的价格为 0.14 美元,比同类模型如 OpenAI 的 o1 更加经济。

限制与未来研究

本文指出了几个需要改进的地方。

- 模型有时在需要特定输出格式的任务上会遇到困难

- 在软件工程任务上的表现有待提升

- 在多语言环境中处理语言混合时会遇到挑战

- 少样本提示法会持续降低性能

未来的工作将集中在解决这些问题的限制,并扩展模型在功能调用能力、多轮对话和复杂角色扮演等方面的能力。

部署和可访问性- 开源许可:DeepSeek-R1及其变体在MIT许可下发布,这种方式对于推动创新和降低AI模型开发的入门门槛非常重要,促进开源合作和商业使用,包括模型的蒸馏过程。

- 模型格式:

模型及其蒸馏版本均支持GGML、GGUF、GPTQ和HF等格式,便于在本地灵活部署。

DeepSeek Chat平台提供了一个易于使用的界面,无需任何设置即可与DeepSeek-R1互动。

- 访问步骤:

- 访问DeepSeek Chat平台

- 注册账号或登录已有账号。

- 登录后,你可以切换到“深度思考”模式以体验DeepSeek-R1的逐步推理能力。

深度聊天平台

2. 使用DeepSeek API访问对于程序访问需求,DeepSeek 提供了一个与 OpenAI 格式兼容的 API,可以集成到各种应用程序中。

如何使用API:

a. 获取 API key:

- 前往DeepSeek API平台注册账号并获取专属API密钥。

b. 配置你的环境。

- 将

base_url设置为[https://api.deepseek.com/v1](https://api.deepseek.com/v1.)。 - 使用您的 API 密钥进行认证,通常通过在 HTTP 头中添加 Bearer Token 进行认证。

c. 调用 API

- 使用API发送提示并接收来自DeepSeek-R1的回复。

- 详细的文档和示例可在DeepSeek API文档中查看。

DeepSeek API:调用示例

3. 本地运行 DeepSeek-R1。两个型号(R1和R1-Zero):

- 硬件要求: 由于其规模较大,完整模型需要大量的硬件支持。推荐使用具有大量显存的GPU(如Nvidia RTX 3090或更高型号)。如果使用CPU,至少需要48GB的RAM和250GB的磁盘空间,但是没有GPU加速的话,性能会比较慢。

- 浓缩模型: 为了在资源需求较低的硬件上实现本地部署,DeepSeek 提供了浓缩版本。这些模型的参数范围从1.5B到70B不等,适用于硬件配置较普通的系统。例如,7B参数的模型可以在至少具有6GB显存的GPU上运行,也可以在以GGML/GGUF格式运行的CPU上运行,大约需要4GB的RAM。

本地运行的软件工具如下:

- 奥拉玛:

你可以使用Ollama本地运行模型:Ollama 是一个让你能在自己的电脑上运行开源AI模型的工具。点击这里下载:https://ollama.com/download

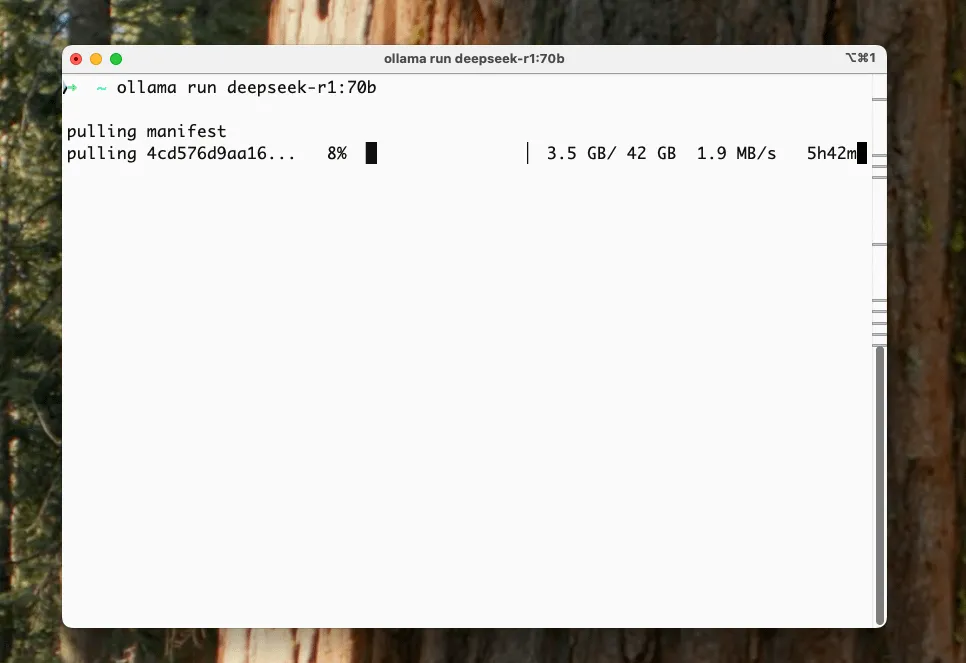

接下来,你需要下载并启动该DeepSeek R1模型。

Ollama 提供不同大小的模型——基本上,模型越大,AI 就越智能,但需要更强大的 GPU。以下是模型阵容:

1.5B 版本(最小的):

ollama run deepseek-r1:1.5b

8B 版本:

ollama run deepseek-r1:8b

14B 版本:

ollama run deepseek-r1:14b

32B 版本:

ollama run deepseek-r1:32b

70B 版本(最大、最聪明):

ollama run deepseek-r1:70b当你刚开始使用DeepSeek-R1进行实验时,建议先从较小的模型开始,以便熟悉设置并确保与您的硬件兼容。您可以在终端中输入以下命令开始此过程:

python run_model.py --model small ollama run deepseek-r1:8b注:此命令用于运行名为 deepseek-r1:8b 的模型。

图片来自Reddit社区的r/macapps

例如,通过Ollama向本地下载的DeepSeek-R1发送请求,

Ollama 提供了一个 API 接口,可以用来程序化地与 DeepSeek-R1 进行交互。在发起 API 请求前,请确保本地的 Ollama 服务器已启动。你可以通过运行命令来启动服务器。

启动 ollama 服务一旦服务器开始运行,你可以用 curl 来发送请求。

curl -X POST http://localhost:11434/api/generate -d '{

"model": "deepseek-r1",

"prompt": "这里输入您的问题或提示"

}'请将您想提供的实际输入进行替换。此命令会向本地 Ollama 服务器发送一个 POST 请求,该服务器会使用指定的 DeepSeek-R1 模型来处理提示,并返回生成的响应。

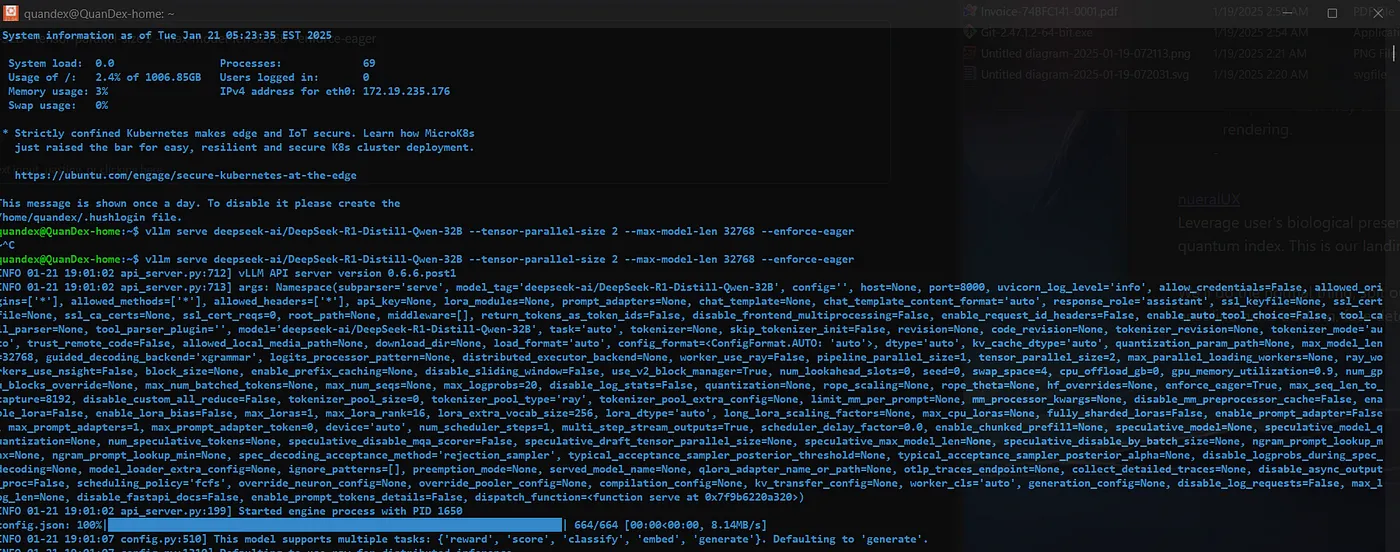

其他在本地运行或访问模型的方法有:vLLM/SGLang: 用于本地运行模型。可以使用这样的命令来服务精简模型:vllm serve deepseek-ai/DeepSeek-R1-Distill-Qwen-32B --tensor-parallel-size 2 --max-model-len 32768 --enforce-eager。

感谢: HuggingFace.

llama.cpp: 你也可以用 llama.cpp 来本地运行模型。

看看其他人用 DeepSeek-R1 建了什么在我的7台M4 Pro Mac Mini 和 1台M4 Max MacBook Pro上跑DeepSeek R1:

DeepSeek R1 1.5B 完全在本地运行,每秒处理60个token,在你的浏览器里借助WebGPU技术。

RAG应用程序使用DeepSeek R1模型在您的电脑上运行,让您能与PDF文件聊天。

在手机上流畅运行1.5B版本的DeepSeek R1应用程序:

轻松解决复杂的数学问题!(用mlx-lm在M4 Max上大约花费了35秒处理了大约3200个令牌的文本。)

结论是:

从 DeepSeek-R1-Zero 到 DeepSeek-R1 的这一转变代表了研究中的一个重要学习旅程。虽然 DeepSeek-R1-Zero 证明了纯强化学习的有效性,而 DeepSeek-R1 则展示了结合监督学习和强化学习能够创造出一个更强大且实用的模型。

合作 🤝: 有没有有趣的 AI 项目想要合作?我们可以一起合作!我有空合作在这里联系我,特别是在这些领域,也热衷于和其他专业人士建立联系。

共同学习,写下你的评论

评论加载中...

作者其他优质文章