我们大家都喜欢人工智能,近几年,人工智能的热潮改变了世界,并引领世界进入了一个新时代。无论遇到什么问题,都可以用人工智能来解决,比如用Gemini查食谱,Chatgpt写作业,Claude写代码,V0做前端设计。程序员和学生现在对人工智能的依赖性非常高,每天都能看到新的AI创业公司出现,主打AI。

这导致像我这样的开发者会想如何才能做出这样的东西?答案就在上面提到的图片中:调用这些模型的 API 即可。但是,像我这样的贫困学生没有能力购买订阅。这让我想到可以本地运行 AI,然后通过端口提供 API 调用。本文将一步步教你如何设置 Ollama 并通过你的 nodejs 代码访问大模型。

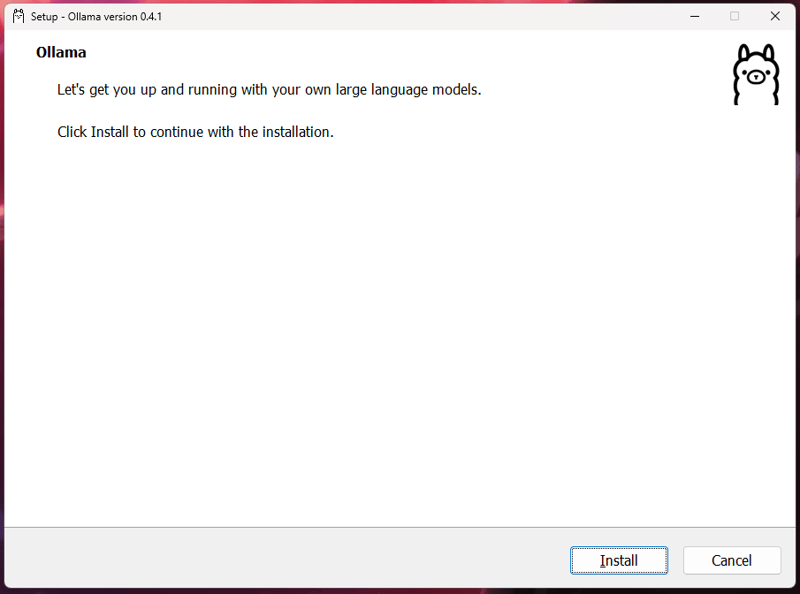

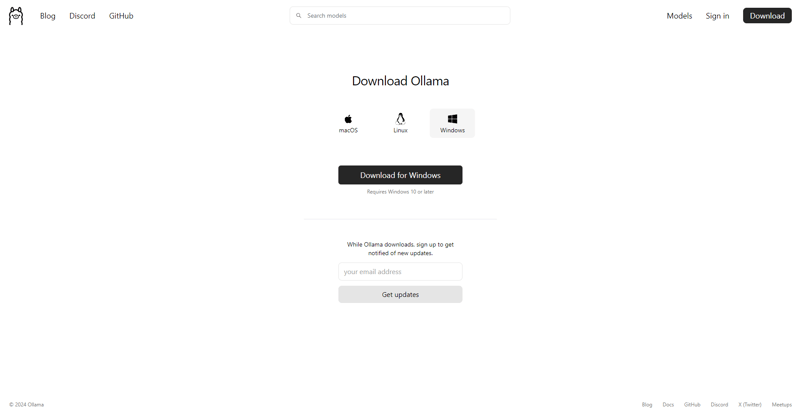

如何安装Ollama此步骤主要是为Windows用户设计的。如果你不是使用Windows系统,请参考此指南。

- 访问 Ollama 网站,然后下载安装程序。

- 完成后,您可以运行安装程序并完成安装。

- 这将把客户端安装到您的电脑上,此时您可以访问 ollama 官方网站的 库 部分选择您想要用的模型。

你可以选择的 Ollama 模型

- 在这里,我将使用codellama:7b模型在我的机器上。

- 打开你的CMD或PowerShell,输入命令

ollama run <model-name>,这会将模型下载到你的机器上(如果已经存在的话,它将不会重新下载),然后运行它。

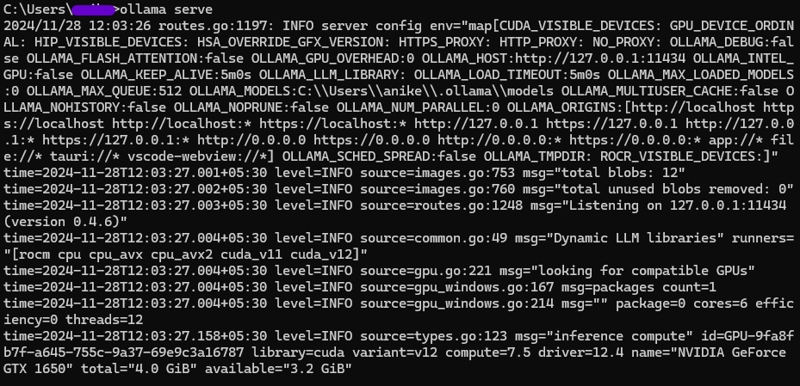

- 如果你想继续,请按照以下步骤操作。现在你已经在系统上安装了Ollama,并且也有了所需的LLM,接下来的步骤就是在你的机器的端口上启动服务,以便你的节点应用能够访问它。

- 在继续之前,请先关闭正在后台运行的Ollama,并使用命令

ollama serve检查分配给ollama的默认端口是否为空,如果这个命令抛出错误,那就意味着该端口已被占用。 - 在继续之前,你需要释放该端口,Ollama的默认端口是

11434 - 使用以下命令检查哪个进程正在监听该端口

netstat -ano | findstr :11434 - 记下结果中的PID,然后使用该命令释放端口。

taskkill /PID <PID> /F - 释放完毕后,打开一个新的CMD窗口并运行以下命令

ollama serve - 现在你应该会看到类似以下的输出,这意味着你的LLMs现在可以通过API调用来访问。

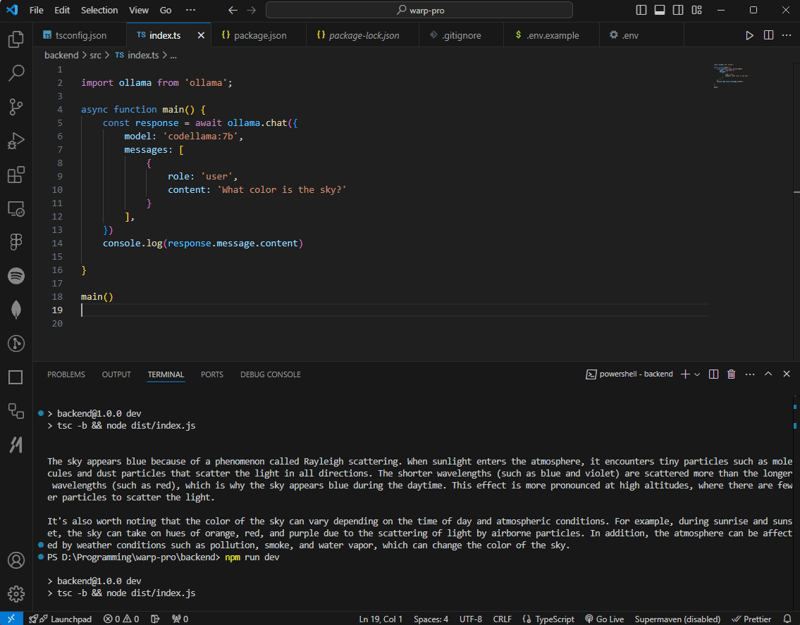

- 按照以下步骤启动您的 Node 项目

npm init -y # 初始化npm项目

npm i typescript ollama # 安装typescript和ollama包

npx tsc --init # 初始化typescript配置文件全屏, 退出全屏

这将为你创建一个可以开始工作的代码仓库,前往 tsconfig.json 文件,取消注释并调整这些值。

"rootDir": "./src",

"outDir": "./dist",全屏模式 退出全屏

- 创建一个名为 src 的文件夹,在该文件夹中创建

index.js文件。

import ollama from 'ollama';

async function main() {

const response = await ollama.chat({

model: 'codellama:7b',

messages: [

{

role: 'user',

content: '天空的颜色是什么?'

}

],

})

console.log(response.message.content)

}

main()全屏 退出全屏

在运行代码前,编辑 package.json 中的脚本内容

"scripts": {

"dev": "tsc -b && node dist/index.js",

"开发脚本": "此脚本用于开发环境,执行编译并运行 dist/index.js"

},进入全屏模式。

退出全屏模式。

- 这会将 ts 代码编译成可以在运行时使用的 js 代码,以及在终端中输入命令

npm run dev来运行应用程序。

- 终于可以用 nodejs 访问你本地的 LLM 了。

- 更多关于 ollama 的信息,你可以在这里查看 here。

谢谢你的阅读,希望这篇文章能对你有所帮助。如果你觉得有用,欢迎随时通过我的社交平台联系我!

我的领英 | GitHub 或 我的码云

点击查看更多内容

为 TA 点赞

评论

共同学习,写下你的评论

评论加载中...

作者其他优质文章

正在加载中

感谢您的支持,我会继续努力的~

扫码打赏,你说多少就多少

赞赏金额会直接到老师账户

支付方式

打开微信扫一扫,即可进行扫码打赏哦