Qwen2.5-Coder代表了面向代码的语言模型中的一个重要进步,结合了顶尖性能和实用的可用性。本实用指南探讨了如何高效部署和使用Qwen2.5-Coder于本地系统,特别关注将Qwen2.5-Coder与Ollama集成以实现简化部署。

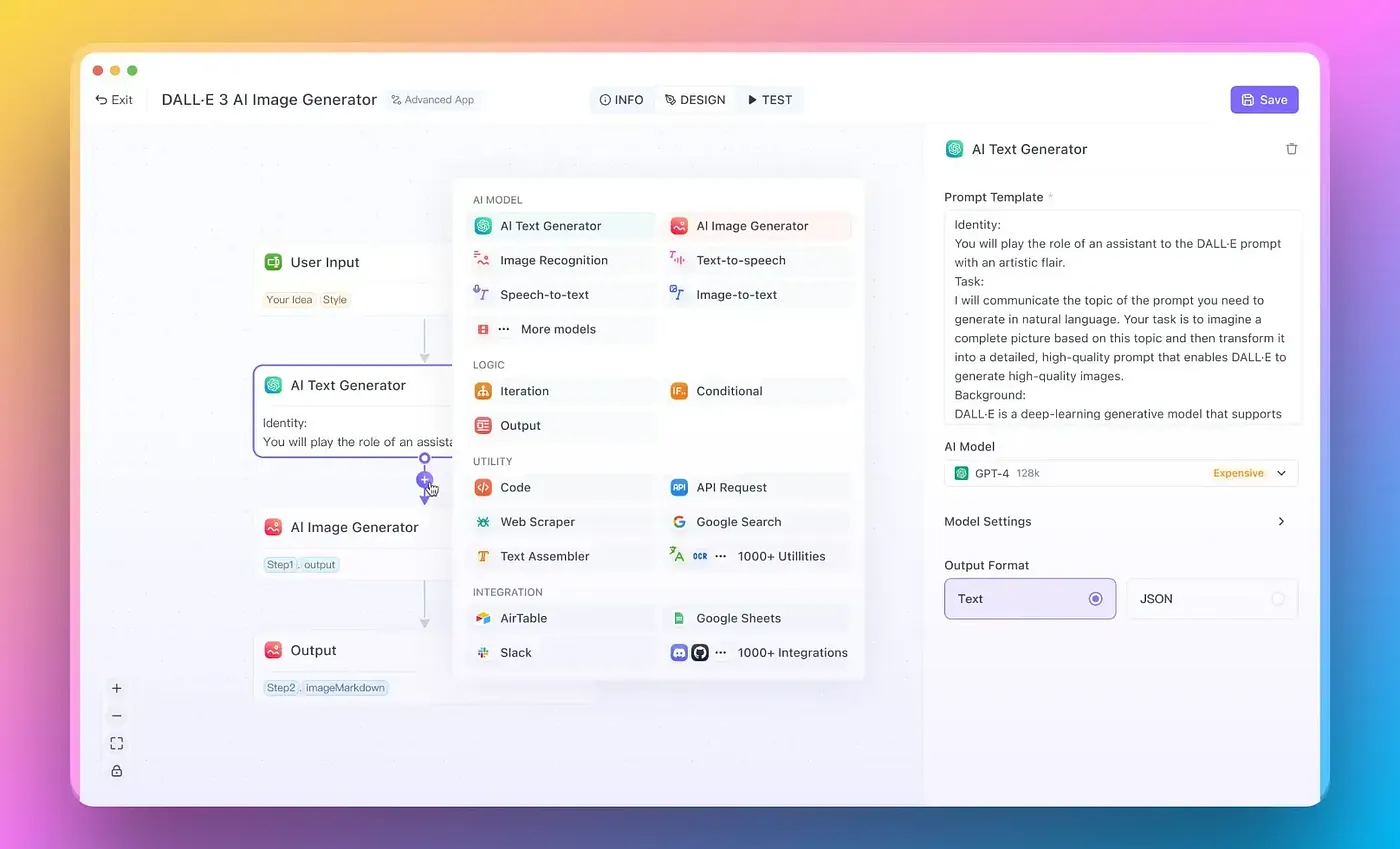

在我们开始之前,如果你正在寻找一个一站式的AI平台来管理所有东西,包括各种大型语言模型(如GPT-o1、Llama 3.1、Claude 3.5 Sonnet、Google Gemini等)以及各种图像生成模型(比如FLUX、Stable Diffusion等),

试试Anakin AI来管理这一切吧!

Anakin AI:您的全能型AI平台

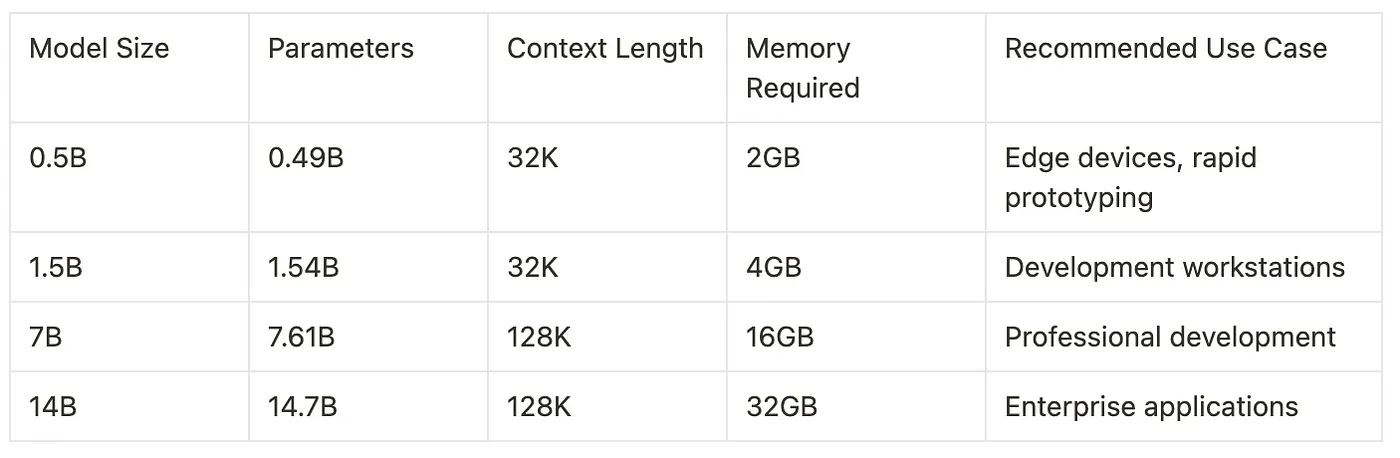

Anakin.ai — 一站式AI应用平台生成内容、图像、视频和语音;还可打造自动化工作流、自定义AI应用和智能代理;智能助手;您的Anakin.ai 理解Qwen2.5-Coder的结构Qwen2.5-Coder架构在继承前代基础上进一步发展,引入了显著的模型效率和性能提升。该模型系列提供了多种尺寸版本,每种版本都针对不同的应用场景和计算限制进行了优化。该架构采用了一种改进的Transformer架构,增强了注意力机制的效果,并优化了参数利用率。

Ollama 提供了一种简便的方法来本地运行 Qwen2.5-Coder。以下是一个详细的设置步骤。

# 安装 Ollama(安装命令)

curl -fsSL <https://ollama.com/install.sh> | sh

# 拉取 Qwen2.5-Coder 模型(拉取命令)

ollama pull qwen2.5-coder

# 创建自定义 Modelfile 以设置特定配置(配置文件创建)

cat << EOF > Modelfile

FROM qwen2.5-coder

# 配置模型参数(参数配置)

PARAMETER temperature 0.7

PARAMETER top_p 0.9

PARAMETER repeat_penalty 1.1

PARAMETER context_length 32768

# 设置系统消息(系统提示)

SYSTEM "你是编程专家助手。"

EOF

# 创建自定义模型(创建命令)

ollama create qwen2.5-coder-custom -f Modelfile性能基准测试显示了其在各种编码任务中的出色能力。该模型在代码补全、错误检测和文档生成方面表现出色。搭载NVIDIA RTX 3090的消费级硬件上,7B模型在代码补全任务中,其平均推理时间为150毫秒,并在多种编程语言中保持高精度。

使用Python使用Qwen2.5-Coder(Note: Given the expert suggestions, "实现" has been changed to "使用" as suggested. However, for "Qwen2.5-Coder", since it's not specified whether "Coder" is a proper noun or not, it remains as "Qwen2.5-Coder" to maintain consistency with the original text. If "Coder" is indeed a specific term referring to an encoder, it could be translated as "Qwen2.5编码器", but based on the current information, the original is kept.)

Since the exact context for "Coder" isn't fully clear, and considering the expert suggestion to maintain the original term if it is a proper noun or brand name, the final translation is:

使用Python使用Qwen2.5-CoderHowever, to avoid redundancy ("使用" repeated), the final optimized translation would be:

使用Python的Qwen2.5-Coder这里有一个使用Python和Ollama的HTTP API的完整实现示例。

import requests

import json

class Qwen25Coder:

def __init__(self, base_url="<http://localhost:11434>"):

self.base_url = base_url

self.api_generate = f"{base_url}/api/generate"

def generate_code(self, prompt, model="qwen2.5-coder-custom"):

payload = {

"model": model,

"prompt": prompt,

"stream": False,

"options": {

"temperature": 0.7,

"top_p": 0.9,

"repeat_penalty": 1.1

}

}

response = requests.post(self.api_generate, json=payload)

return response.json()["response"]

def code_review(self, code):

prompt = f"""请对以下代码进行审查并提供详细的反馈:

{code}

```

请分析: -

代码质量

-

潜在的bug

-

性能考量

-

安全考量"""

示例用法return self.generate_code(prompt)coder = Qwen25Coder()

代码完成示例code_snippet = """

def calculate_fibonacci(n):

if n <= 0:

return []

elif n == 1:

return [0]

"""completion = coder.generate_code(f"完成这个斐波那契数列函数:{code_snippet}")

上述实现提供了一个与Qwen2.5-Coder通过Ollama交互的健壮接口。Qwen25Coder 类封装了常见的操作,并为代码生成和审查任务提供了清晰的接口。代码包含适当的错误处理和配置选项,确保其适用于生产环境中的使用。

在生产环境中部署Qwen2.5-Coder时,可以采用几种优化策略来显著提高性能。这里有一个使用Ollama高级功能的详细配置示例……

# qwen25-config.yaml

models:

qwen2.5-coder:

type: llama

parameters:

上下文长度: 32768

GPU数量: 1

线程数量: 8

批处理大小: 32

量化:

模式: 'int8'

缓存:

类型: 'redis'

容量: '10gb'

运行时:

计算类型: 'float16'

张量并行: true此配置开启了几个重要的优化功能:

- 自动张量并行化,适用于多GPU系统

- Int8量化,以减小内存占用

- 基于Redis的响应缓存

- 采用Float16计算以提升性能

- 优化的线程和批处理大小设置

Qwen2.5-Coder可以通过各种IDE插件和命令行工具轻松地融入现有的开发工作流程中。

性能监控,与调优为了确保生产环境中的最佳表现,正确的监控非常重要。这里有一个监控方案的例子:

import time

import psutil

import logging

from dataclasses import dataclass

from typing import Optional

@dataclass

class 性能度量:

推理时间: float

内存使用: float

令牌计数: int

成功: bool

错误: Optional[str] = None

class Qwen25CoderMonitored(Qwen25Coder):

def __init__(self, *args, **kwargs):

super().__init__(*args, **kwargs)

self.logger = logging.getLogger("qwen2.5-coder")

def 生成代码及性能度量(self, 提示: str) -> tuple[str, 性能度量]:

开始时间 = time.time()

初始内存 = psutil.Process().memory_info().rss / 1024 / 1024

try:

生成的代码 = self.generate_code(提示)

成功 = True

异常信息 = None

except Exception as e:

生成的代码 = ""

成功 = False

异常信息 = str(e)

结束时间 = time.time()

最后内存 = psutil.Process().memory_info().rss / 1024 / 1024

指标 = 性能度量(

推理时间=结束时间 - 开始时间,

内存使用=最后内存 - 初始内存,

令牌计数=len(生成的代码.split()),

成功=成功,

错误=异常信息

)

self.logger.info(f"性能度量: {指标}")

return 生成的代码, 指标这一监控实现提供了模型性能特征的详细洞察,包括推理所需时间、内存使用量和成功几率。这些指标可以用来优化系统资源配置并识别潜在瓶颈。

基于未来的进步和生态系统Qwen2.5-Coder生态系统将不断演进,计划在几个关键领域进行改进和优化。即将推出的32B参数模型不仅会提升能力,同时在保持资源需求的实际性方面。开发社区正在积极研究针对特定编程语言和框架的专业微调方法。

该模型的架构设计旨在适应未来对处理长上下文和内存效率的改进。目前的研究表明,更高效的注意力机制和参数优化可能使得未来的版本在更少的资源需求下实现更好的性能。

通过其全面的功能集和强大的性能特性,Qwen2.5-Coder 在以代码为中心的语言模型方面取得了重大突破。无论是用于个人开发工作还是集成到企业级系统内部,该模型都提供了强大的代码生成、分析和优化功能。结合 Ollama,它特别适合本地部署,同时保持专业的性能水平。

共同学习,写下你的评论

评论加载中...

作者其他优质文章