此标题通俗易懂地反映了文章内容,同时使用了符合中文口语习惯的表达方式。

焕新的DenseNet (RDNet),超越了Swin Transformer,ConvNeXt,和DeiT-III,匹敌MogaNetDenseNets 重生版:超越ResNets和ViTs的范式转变

RDNet,由NAVER Cloud AI和NAVER AI Lab开发

2024 ECCV (Sik-Ho Tsang @ Medium)图像分类(1989 … 2023)

[Vision Permutator (ViP)] [ConvMixer] [CrossFormer++] [FastViT] [EfficientFormerV2] [MobileViTv2] [ConvNeXt V2] [SwiftFormer] [OpenCLIP] 2024[FasterViT] [CAS-ViT] [TinySaver]

更多相关阅读请参见

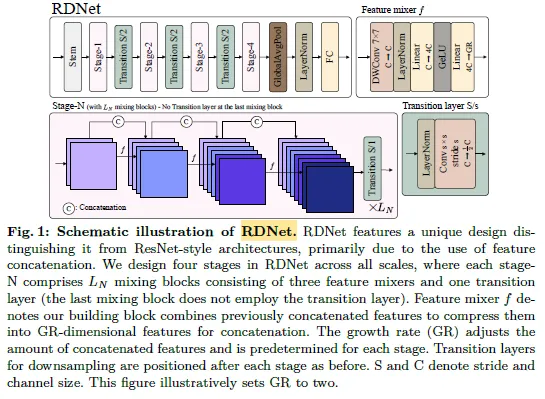

- DenseNet 重新审视,进行了架构调整、模块重新设计,以及改进的训练方案,以增加模型的宽度并提高内存效率。

- 最终,形成了RDNet,并最终超过了Swin Transformer、ConvNeXt 和 DeiT-III,并与MogaNet。

- RDNet

- 成果

- (在阅读这个故事之前,最好先了解一下[DenseNet]。)

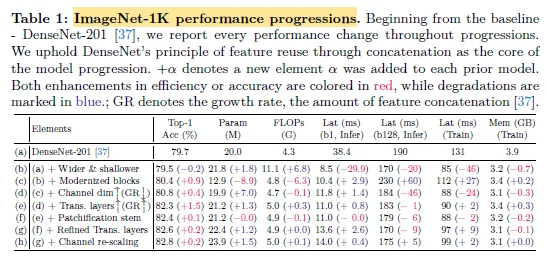

- 从DenseNet-121 开始,应用了现代的训练设置,如标签平滑(Label Smoothing)、RandAugment、随机擦除、Mixup、CutMix、随机深度(Stochastic Depth)。

- 以下是用于优化DenseNet的实用细节如下,

- 通过增加生长率(GR)来扩大网络的结构,同时减少其深度,以实现这一目标。具体来说,这里将GR从32大幅提升至120。

- 每阶段的块数进行了调整,从(6, 12, 48, 32)减少到一个更小的(3, 3, 12, 3),以进行深度调整。

- 训练速度和内存分别大约减少了35%和18%。GFLOPs显著增加至11.1,后续元素会对此进行相应的调整。

- 使用层归一化(LN)而不是批次归一化(BN);采用后激活;使用深度卷积;减少归一化和激活的次数;并且使用卷积核大小为7。

- 这种设计显著提高了准确率(+0.9%),同时略微增加了计算成本。

- 较大的输入维度对于深度卷积至关重要。* 块内的中间张量尺寸被扩展,超过了输入维度,(例如,扩展比ER被调整为6)。

- GR可以减少到一半,例如:从120到60。

- 这样不仅实现了21%的更快训练速度,还实现了0.4%p的准确率提升。

- 过渡层不仅在每个阶段之后使用,而是在每三个步长为1的块之后使用。

- 这些过渡层更注重维度减少而非下采样。

- 这种变化通常能提高准确性。

- 使用图像块作为模型初始层的输入。采用的设置是补丁大小为4、步幅为4。

- 这使得计算速度显著加快,而没有牺牲精度。

- 由于拼接特征的多样性,需要对通道进行重新缩放。

- 它带来了微小的+0.2%的提升。

增强型密集网络(RDNet)

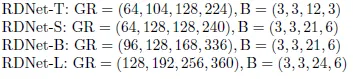

- 一个RDNet家族成员是由不同的GR和Block(B)组合构建的,如上所示。

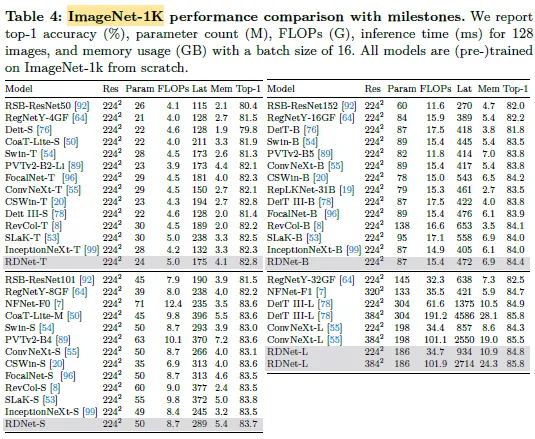

ImageNet(一个计算机视觉领域的著名图像数据集)

ImageNet(一个图像识别数据集)

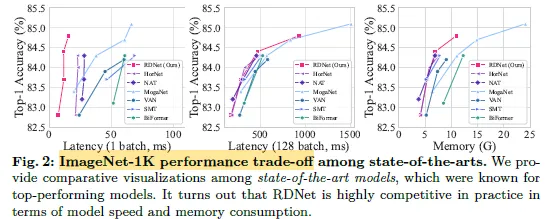

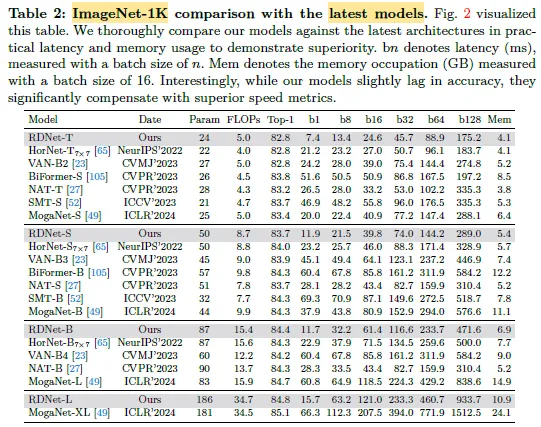

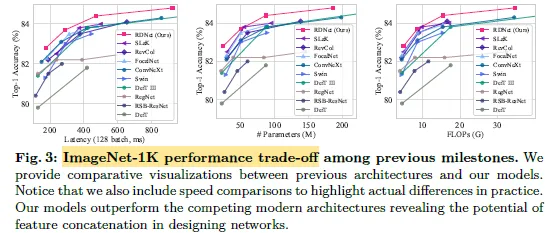

RDNets在准确率上略逊一筹,但在速度上则有显著提升。

- 例如,RDNet-S 可以与较轻量的模型如 SMT-S 或 MogaNet-S 匹配使用。值得注意的是,RDNets 并不像 RDNet 那样占用大量内存,而是实现了更高的效率和更好的性能。

ImageNet

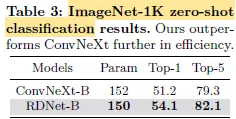

2.2. 零样本图像识别RDNets 凭借高精度、合理的内存使用和更快的运行速度,超越了竞争对手。

Imagenet零样本分类 (Zero-Shot)

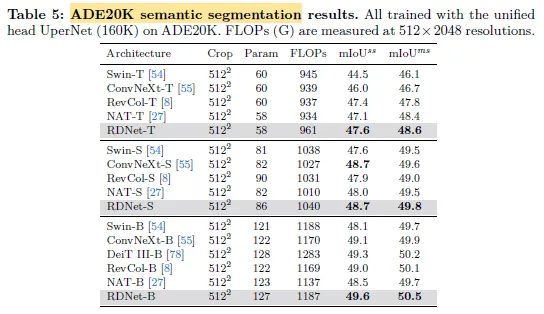

2.3. 后续任务

RDNet表现出色的性能,这表明它在密集预测任务上的出色表现。

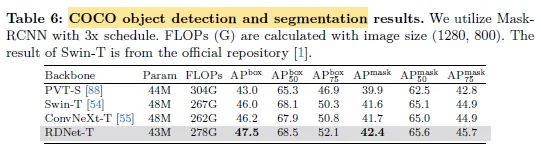

可可

RDNet在COCO上具有强劲的性能。

- 还有好多没提到的实验,可以直接看论文原文哦。

点击查看更多内容

为 TA 点赞

评论

共同学习,写下你的评论

评论加载中...

作者其他优质文章

正在加载中

感谢您的支持,我会继续努力的~

扫码打赏,你说多少就多少

赞赏金额会直接到老师账户

支付方式

打开微信扫一扫,即可进行扫码打赏哦