🔍 NVIDIA GPU的全面比较分析

瑞典

简介

大型语言模型(LLM) 如 GPT-4,BERT 以及其他 基于变压器的模型 已经 极大地改变了人工智能领域的面貌。这些模型在 训练 和 推理 过程中需要 大量的计算资源。选择合适的 用于LLM推理的GPU 可以极大地影响 性能、性价比 和 可扩展性。💡

🔍 本指南将帮助您选择最适合您需求的GPU,无论您是为个人项目、研究环境还是大规模的生产部署。🎯

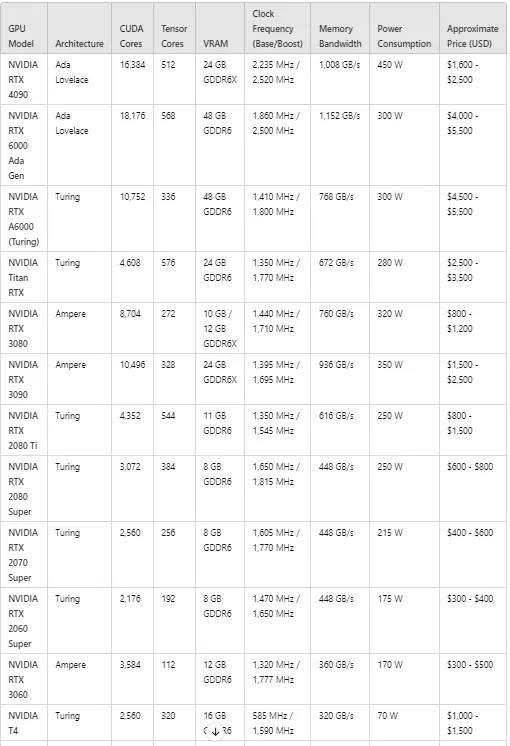

要了解关键的NVIDIA GPU规格在开始看列表之前,我们来快速回顾一下使GPU适合LLM推理的关键规格:

- 🖥️ CUDA 核心 :这些是 GPU 的 主要处理单元 。更高的 CUDA 核心数量 通常意味着更好的 并行处理性能 。

- 🧠 张量核心 :专为 深度学习任务 设计的特殊核心,例如矩阵乘法,这对于神经网络操作来说非常重要。

- 💾 VRAM(视频 RAM) :这是 GPU 可用的 内存 ,用于 存储数据和模型 。更多的 VRAM 允许更高效地处理 更大的模型和数据集 。

- ⏱️ 时钟频率 :表示 GPU 运行的速度 ,以 MHz 为单位。更高的频率 通常意味着更好的 性能表现 。

- 🚀 内存带宽 :这是 数据从或写入 VRAM 的速率 ,这对 如 LLM 推理等任务的性能 有很大影响。

- ⚡ 功耗 :以瓦特 (W) 为单位测量,指示 GPU 在运行时将消耗的 功率 。更高的功耗 会增加冷却和能源成本。

- 💰 价格 :GPU 的成本是关键因素,特别是对于有 预算限制 的企业或研究实验室。必须平衡 性能需求与价格 。

- 适用于 LLM 推理

以下表格基于性能和价格对NVIDIA显卡适合LLM推理进行了排名:

消费级和专业级GPU顶 超火的LLM推理

🔷 NVIDIA H200 :

- 最适合于:需要最大性能和内存带宽的企业级AI部署,以支持大型LLM推理工作负载的。

- 性能:出色的GPU性能,拥有18,432个CUDA核心,96GB HBM3内存,以及惊人的4,000GB/s带宽。

🔷 NVIDIA H100:

- 最佳适用于:专注于大规模LLM推理的企业和研究实验室。

- 性能:配备了16,896个CUDA核心和80GB的HBM3,H100在高性能和低功耗之间取得了平衡,非常适合处理AI驱动的工作负载。

🔷 NVIDIA A100: 英伟达A100 (高性能GPU)

- 最适合的组织:适合那些需要高性能 AI 推理和训练,同时又希望价格低于 H100 的组织。

- 性能:提供巨大的内存带宽(1,555 GB/s),并提供 40 GB 或 80 GB HBM2e 内存选项,非常适合对性能要求高的 AI 模型。

🔹 英伟达RTX 6000 Ada Gen

- 最适合于:专业LLM推理任务,侧重于不使用HBM3的高性能。

- 性能:提供48GB的GDDR6内存,18,176个CUDA核心,以及性能与价格之间的平衡表现,适合较小的企业或研究机构。

🔷 NVIDIA L40 显卡:

- 最佳选择:中型企业高绩效AI推理的理想选择。

- 性能:L40表现出色的性能,配备9,728 Tensor核心和48 GB GDDR6内存,并且能耗低于H100。

🔷 NVIDIA RTX 4090 参数:

- 最适合用于:高端消费级AI推理设置。

- 性能:配备 24 GB的GDDR6X内存 和 1,008 GB/s的内存带宽。对于消费级GPU来说,其性能极为出色,尽管它的450 W功耗相对较高。这使其在具备竞争力的价格范围内成为高性能任务的理想选择。

🔹 NVIDIA RTX 6000 阿达洛世代 :

- 最适合用于:需要大容量内存和高吞吐量的专业AI工作负载。

- 性能:提供48 GB的GDDR6内存,大量的CUDA和Tensor核心数量,1,152 GB/s的内存带宽。支持超大规模数据传输和LLM推理任务的高效执行。

🔷 NVIDIA Titan RTX :英伟达泰坦RTX

- 最适合:适合需要强大张量核心性能进行专业AI开发和推理的AI开发者。

- 性能:拥有 24 GB GDDR6内存 和 672 GB/s的内存带宽 ,Titan RTX在LLM推理和深度学习任务中表现出可靠性能,不过,它没有最新的架构改进。

🔷 NVIDIA RTX 3080 & RTX 3090: 两款显卡:

- 最适合于:高性能游戏和AI开发,特别是对于那些需要更强性能且价格更亲民的开发者。

- 性能:这两款GPU都拥有出色的性价比,其中RTX 3090 拥有 24GB的GDDR6X内存,这使得它特别适合内存密集型的AI任务。这些型号在从事AI和游戏开发的开发者中很受欢迎。

🔷 英伟达T4 :(一款高性能的图形处理单元)

- 最适合于:基于云的推理工作负载或需要更低功耗的边缘计算场景。

- 性能:T4 在低功耗下进行了优化(16 GB 的 GDDR6 内存),但仍能为云或边缘AI推理工作负载提供不错的性能,非常适合功耗敏感的AI应用。

选择适合LLM推理的正确GPU主要取决于项目的规模、模型的复杂程度以及您的预算约束。

- 针对企业级部署场景,像NVIDIA H200和H100这样的GPU提供了卓越的性能,具有庞大的CUDA和张量核心数量,高VRAM和惊人的内存带宽,使其成为运行最大模型和最密集的人工智能任务的理想选择。虽然这些GPU价格较高,但为尖端的人工智能应用和大规模LLM推理提供了必要的计算能力。

- 对于寻求高性能但价格较低的组织来说,NVIDIA A100和RTX 6000 Ada Generation平衡了性能和成本,提供了优秀的性能,拥有大量的VRAM和强大的张量核心性能,适用于推理任务。它们特别适合中型企业和研究机构,这些机构正在寻找高效且强大的硬件。

- 如果成本和能效是关键考虑因素,像NVIDIA L40和A40这样的GPU提供了稳定的张量核心数量,高VRAM容量和高效的能耗。这些是适用于中型组织的高性能AI任务的优秀选择。

- 对于较小的团队或个体开发者来说,消费级的GPU如NVIDIA RTX 4090或RTX 3090是不错的选择,它们提供强大的性能,价格仅为专业级GPU的一部分,这些GPU具有高CUDA和张量核心数量以及大量的VRAM,适用于本地AI开发平台或较小规模的LLM推理任务。价格在1500美元至2500美元之间,它们为希望拥有强大硬件但预算有限的人工智能从业者提供了很好的价值。

- 对于基于云的推理或边缘计算,NVIDIA T4和P100提供了专业级LLM推理的经济入门方案,具有较低的能耗,非常适合较轻的推理任务和较小的人工智能应用。

“🚀 喜欢这些内容吗?不要忘了关注、鼓掌 👏,并关注更多精彩内容! 🔥👀”

点击查看更多内容

为 TA 点赞

评论

共同学习,写下你的评论

评论加载中...

作者其他优质文章

正在加载中

感谢您的支持,我会继续努力的~

扫码打赏,你说多少就多少

赞赏金额会直接到老师账户

支付方式

打开微信扫一扫,即可进行扫码打赏哦