源-奥拉玛(ollama,注:ollama可能是纳瓦特尔语的词,特指墨西哥原住民语言中的一种概念或术语)

Ollama 是开发人员和爱好者的变革工具,特别是在处理大型语言模型(LLMs)时。它使您能够在本地机器上直接运行这些强大的 AI 模型,相比封闭源代码的云解决方案,它提供了更高的透明度、控制和自定义能力。本文将深入探讨 Ollama,提供了关于其工作原理、安装流程以及无缝运行模型的能力的全面指南。

什么是Ollama?本质上,Ollama 是一个软件平台,旨在简化在本地计算机上运行开源大型语言模型的过程。它消除管理模型权重、配置和依赖项的复杂性,使您能够专注于与大型语言模型交互并探索其功能和潜力。

以下是对Ollama所提供服务的概览:

- 本地运行: 在您的机器上直接运行LLM,提供对资源和隐私的更全面控制。

- 开源模型重点: 主要与开源模型合作,促进透明度和定制。

- 简化工作流: Ollama简化了流程,使开始和实验LLM更加简单。

- 灵活性: 支持各种开源模型,并通过Modelfiles提供定制选项。

Ollama 通过创建一个容器化环境来运行。该容器封装了所有必要的组件:

- 模型权重: 决定大语言模型能力的核心参数。

- 配置文件: 定义模型运行方式的配置文件。

- 依赖项: 模型运行所需的软件库和工具。

通过将这些元素通过容器化技术,Ollama 确保了每个模型具有一致性和隔离性环境,无论您的系统配置为何。这简化了部署过程,并避免与机器上其他软件产生潜在冲突。

这里是对工作流程图的简化说明:

- 选择一个大规模语言模型: Ollama支持多种开源模型,如Llama 3、Mistral、Phi-3、Code Llama和Gemma。

- 定义模型配置(可选): 对于高级用户,Ollama允许通过一个Modelfile来自定义模型的行为,此文件可以指定特定版本的模型、硬件加速选项等配置细节。

- 运行大规模语言模型: Ollama提供了用户友好的命令来创建容器,下载模型权重,并启动大规模语言模型以进行交互。

- 与大规模语言模型交互: 运行后,你可以通过Ollama的库或用户界面(取决于所选模型)向大规模语言模型发送提示和请求。大规模语言模型将处理你的输入并生成响应。

让我们来看看,安装过程:

- 系统要求:

- Ollama 与 macOS、Linux 兼容,并支持 Windows(预览版)。

- 对于 Windows,请确保使用 Windows 10 或更新版本。

ollama 官方下载页

2.下载和安装:

- 访问Ollama网站下载Windows版本的安装程序。

- 按照标准安装流程操作。

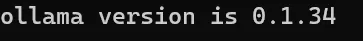

3.核实

- 打开终端或命令提示符。

- 输入

ollama --version以验证 Ollama 已正确安装。

由作者创作

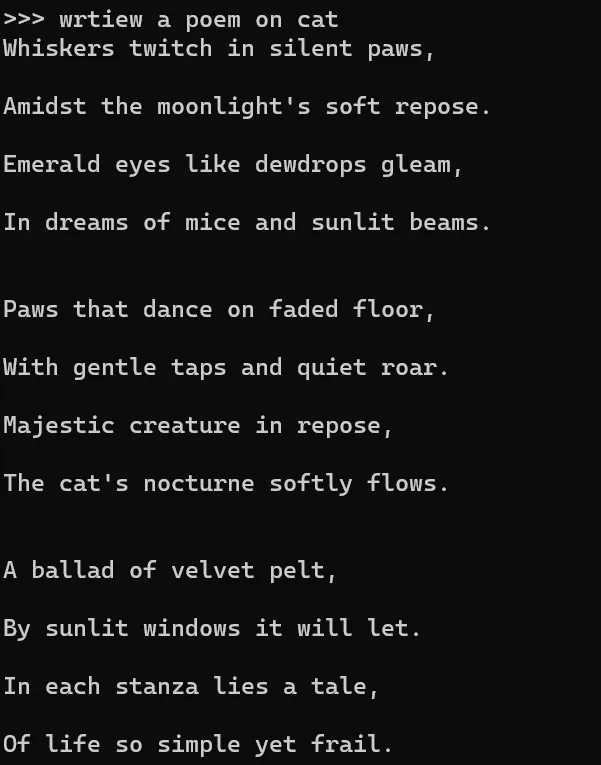

使用Ollama运行模型时:现在,让我们来看看如何使用Ollama模型:

- 加载模型:

- 使用CLI加载您所需的模型。

ollama 运行 llama22.生成文本指令:

- 加载模型后,通过以下方式生成文本

写一首以猫为题的诗吧。

由作者使用phi3(ollama)生成

运行第一个自定义模型的步骤:Ollama 提供了一种运行大型语言模型的直接方法。以下是该流程的详细说明:

- 选择一个模型: 浏览 Ollama. 支持的可用开源大语言模型选项。考虑模型的大小、功能特性以及您的具体需求。

- 创建 Modelfile: 如果您想自定义模型配置,根据 Ollama 的文档(https://github.com/ollama/ollama)创建一个 Modelfile。此文件允许您指定模型版本、硬件加速选项(如果适用)和其他配置细节。

- 创建模型容器: 使用

ollama create命令加上可选的模型名称(以及可选的 Modelfile 路径)来启动容器创建流程。Ollama 将下载必要的模型权重并配置相应的运行环境。

ollama 创建模型 model_name [-f 路径/到/Model文件]4.运行模型(可选): 容器创建完成后,使用 ollama run 命令并指定模型名称来启动大型语言模型。

ollama run 模型名5. 与运行中的LLM进行交互的具体方法取决于所选的模型。某些模型可能提供命令行界面,而其他模型可能需要与Python库进行集成。请参阅相应特定模型的文档以获取详细说明。

这里有一个示例场景,使用一个假设的大型语言模型(LLM)通过命令行界面接收提示。

ollama 调用 model_name 生成一首关于猫的诗在本地使用 Ollama 运行 LLMs(Large Language Models,大型语言模型)有以下几个优点:

- 隐私: 在您的本地机器上保留数据和与LLM的交互,提供比基于云的解决方案更大的隐私。

- 自定义: Ollama 通过 Modelfiles 提供自定义功能,使您能够根据特定需求调整 LLM 的行为。

- 离线使用: 即使没有互联网连接,也可以离线运行 LLM,因为模型及其所有依赖项都存储在本地。

- 实验: Ollama 提供了一个方便的平台,用于各种开源 LLM 的实验和探索,帮助用户深入研究和发现。

Ollama 是一个革命性的工具,适用于任何对大规模语言模型感兴趣的人。它使开发人员和爱好者能够直接在其本地机器上利用这些高级 AI 模型的强大功能,促进创新、探索并加深理解。凭借其用户友好的界面和对开源模型的重视,Ollama 正在为大规模语言模型技术的更易于访问和透明的未来铺平道路。

资源:Ollama 官方网站: https://ollama.com/

Ollama Github: https://github.com/ollama/ollama?tab=readme-ov-file

快捷参考表: https://cheatsheet.md/llm-leaderboard/ollama.en

请随意使用这些资源,祝你学习顺利!

如果你有任何问题,欢迎随时提问。 😊

共同学习,写下你的评论

评论加载中...

作者其他优质文章