我们使用的计算机的全称叫电子计算机,前面有电子两个字,这说的是整个计算机中的核心元器件基本上都是电子单元组成的。但机械硬盘却是一个特殊的例外,它更多是用机械技术做出来的一个产品。当把带有机械技术基因的磁盘搭到计算机,尤其是再应用到服务器领域的时候,暴露出了机械技术的两个严重问题:

- 第一,速度慢。 如果把内存和CPU的速度比作汽车和飞机的话,这个大哥毫秒级别的延迟几乎就是牛车级别的。

- 第二,容易坏。 经常听说谁谁的磁盘坏了,很少有听说过谁的内存条,CPU坏了。笔者就有在读研期间实验室里正在拷贝资料,突然一个断电直接废了一块硬盘的经历。

要想保证服务器运转的稳定和高速,就必须解决硬盘从娘胎里带出来的这两个缺陷。

多硬盘连接

问题简单明了,我们要解决速度慢、容易坏两个问题。很自然,单兵作战不行,那我们就想到往上怼一个班,多块硬盘一起上。但问题是,假如给你N块硬盘,让你来出一个技术方案,你会怎么设计呢?

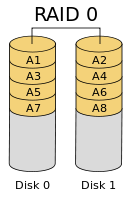

第一个方案就是,把一个文件分成N片,每一片都散列在不同的硬盘上。这样当文件进行读取的时候,就可以N块硬盘一起来工作,从而达到读取速度提高到N倍的效果,这就是RAID 0。

不过这个方案没有解决容易坏的问题,任何一块硬盘坏了都会导致存储系统故障。

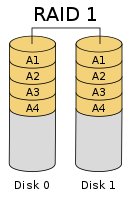

第二个方案就是,仍然把文件分片,但是所有的分片都存在一块硬盘上,其它的硬盘只存拷贝。 这既提高了硬盘的访问速度,也解决了坏的问题。任意一块硬盘坏了,存储系统都可以正常使用,只不过速度会打一点折扣。

不过这个方案又带来了新的问题,那就是实现成本有点高了。假如我们用256G硬盘想实现512G的存储容量的话,最少得需要4块硬盘才能实现。

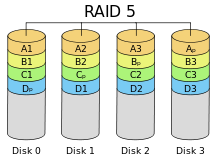

有没有折中一点的方案呢?有,而且很多。我们这里只说下最常见的raid5

RAID 5同样要对文件进行分片,但是不对存储的数据进行备份,而是会再单独存一个校验数据片。

假如文件分为A1 A2 A3,然后需要再存一个校验片到别的磁盘上。这样不管A1,A2还是A3那一片丢失了,都可以根据另外两片和校验片合成出来。 既保证了数据的安全性,又只用了一块磁盘做冗余存储。

假如我们有8块256GB的硬盘,那么RAID5方案下的磁盘阵列从用户角度来看可用的存储空间是7*256GB,只“浪费”了一块盘的空间,所以目前RAID5应用比较广泛~~

Raid卡缓存

硬盘延迟是毫秒级别的,即使是多快硬盘并行,也只能提升数倍而已,不能够达到量级的提升。和CPU内存的纳秒级别工作频率比起来,还是太慢了。

在计算机界,没有缓存解决不了的速度问题,如果有,那就再加一层。现代磁盘本身也基本都带了缓存,另外在一些比较新的raid卡里,硬件开发者们又搞出来了一层“内存”,并且还自己附带一块电池,这就是RAID卡缓存。 我们看下几款主流RAID卡的配置:

- PERC S120 入门软件阵列卡,主板集成无缓存 支持RAID0 1

- PERC H330 入门硬件RAID卡,无板载缓存, 支持RAID 0 1 5 10 50

- PERC H730 主流硬件RAID卡带有1G缓存和电池 支持RAID 0 1 5 6 10 50 60

- PERC H730P 高性能硬件RAID卡带有2G缓存和电池 支持RAID 0 1 5 6 10 50 60

- PERC H830 同H730P,没有内置接口,使用外置接口连接附加存储磁盘柜用

拿目前服务器端出镜率比较高的H730和H730P来看,他们分别带了1G和2G的缓存卡,并且自带电池。 电池的作用就是当发现主机意外断电的时候,能够快速把缓存中的数据写回到磁盘中去。对于写入,一般操作系统写到这个RAID卡里就完事了,所以速度快。对于读取也是,只要缓存里有,就不会透传到磁盘的机械轴上。

另外想再补充说一点的就是文件相关函数里设置DIRECT I/O仅仅只能绕开操作系统本身的Page Cache,而RAID卡里的缓存,对于Linux来说,可以说算是一个黑盒。换句话说,就是操作系统并不清楚RAID卡是从缓存里吐的数据,还是真正从硬盘里读的。

动手查看你的RAID配置

了解了raid基本原理以后,我们可以实际动手查看一下机器上的raid情况。这里拿我手头的一台服务器举例。

通过cat /proc/scsi/scsi,我们可以查看到raid卡的型号

Host: scsi10 Channel: 02 Id: 01 Lun: 00

Vendor: DELL Model: PERC H730 Mini Rev: 4.27

Type: Direct-Access ANSI SCSI revision: 05

可以看到我的这台服务器raid卡使用的是PERC H730, 这块RAID卡带有1G缓存和电池。

再看我们的硬盘阵列

# /opt/MegaRAID/MegaCli/MegaCli64 -LDInfo -Lall -aALL

Virtual Drive: 1 (Target Id: 1)

Name :

RAID Level : Primary-5, Secondary-0, RAID Level Qualifier-3

Size : 1.633 TB

Sector Size : 512

Is VD emulated : No

Parity Size : 278.875 GB

State : Optimal

Strip Size : 128 KB

Number Of Drives : 7

Span Depth : 1

RAID Level列标明的就是当前RAID组的RAIN级别。对照下面

- RAID 1: Primary-1, Secondary-0, RAID Level Qualifier-0 RAID 1

- RAID 0: Primary-0, Secondary-0, RAID Level Qualifier-0 RAID 0

- RAID 5: Primary-5, Secondary-0, RAID Level Qualifier-3 RAID 5

- RAID 10: Primary-1, Secondary-3, RAID Level Qualifier-0 RAID 10

可以看到,本机RAID Level是RAID5。

另外Strip Size叫做条带大小,我机器上的配置是128KB。假如有一个512KB的文件,它就会被分成4个条带,每个128KB。这些条带可能会分散在不同的磁盘上,如果一次性读取的话,多个硬盘就可以一起转动机械轴,读取速度就会提高到原来的数倍。不过要说明的是,如果文件小于这个条带大小,小于128K,那么RAID下的多块硬盘对于该文件的读取耗时也不会有帮助。

继续查看组成RAID的所有的磁盘的状况:

#/opt/MegaRAID/MegaCli/MegaCli64 -PDList -aALL

......

Drive's position: DiskGroup: 1, Span: 0, Arm: 0

Device Id: 1

...

Raw Size: 279.396 GB [0x22ecb25c Sectors]

Non Coerced Size: 278.896 GB [0x22dcb25c Sectors]

Coerced Size: 278.875 GB [0x22dc0000 Sectors]

Sector Size: 512

Logical Sector Size: 512

Physical Sector Size: 512

Inquiry Data: SEAGATE ST300MM0008 TT31S42310JR

...

...

...

Drive's position: DiskGroup: 1, Span: 0, Arm: 6

Device Id: 7

Raw Size: 279.396 GB [0x22ecb25c Sectors]

Non Coerced Size: 278.896 GB [0x22dcb25c Sectors]

Coerced Size: 278.875 GB [0x22dc0000 Sectors]

看到属于DiskGroup 1的总共有7块硬盘,每块的大小都是278GB左右。6块盘的总容量大小就是1.6T左右,确实是只“浪费”了一块硬盘的容量来保障数据的安全性!

另外Inquiry Data也显示了硬盘的制造商,已经型号。这些磁盘都是希捷的300G的机械硬盘,经Google查询其转速为1万转每分钟。

本文小节

机械技术和电子技术比较起来,稳定性要差很多。所以机械背景出身的硬盘既慢又容易坏。为了解决这个问题,RAID技术应运而生。通过一定的冗余原始存储或者校验数据提供安全性的保障,通过增加带电子基因的缓存,合理调度多块磁盘的机械轴,提高了磁盘IO的读写速度。在Linux下可以通过MegaCli工具来查看你的RAID组情况,强烈你建议实际动手查看一下!

在这里我不是单纯介绍技术理论,也不只介绍实践经验。而是把理论与实践结合起来,用实践加深对理论的理解、用理论提高你的技术实践能力。欢迎你来关注我的公众号,也请分享给你的好友~~~~

共同学习,写下你的评论

评论加载中...

作者其他优质文章