看图,永远比看字省事。

比如说,相比看文字版小说,看小说改编的漫画更简单轻松。

那么,如何把一段故事自动变成漫画呢?

AI已经可以做到了。给它一段故事,它就可以用图片把故事讲出来,稍加修改,就变成了一套连环画。

像这样的一段故事:

很久以前, 有个小男孩在森林里迷路了, 他走了好久, 都走饿了, 他很想吃妈妈做的饼, 可这时候小男孩回不去呀, 于是他就在地上画了一个大大的饼, 还在饼上点 上芝麻。

小男孩看着看着, 好像自己已经吃上了大饼, 于是他觉得自己不是很饿了, 重新站起来沿着一条小路走.。

很快, 小男孩的爸妈就找到了他, 他们一起回到家, 吃上了真正香喷喷的饼。

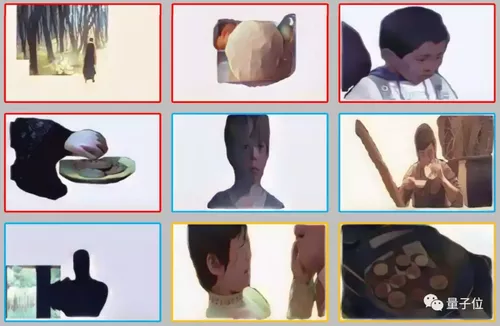

AI可以把它变成这样的漫画:

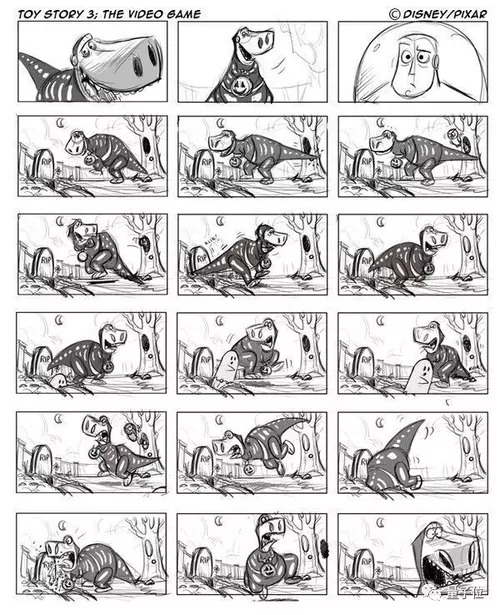

而且,这种漫画形式还可以在电影工业中充当故事板,辅助电影人们进行艺术创作。

找到能讲故事的图

那么这个过程是怎样实现的呢?

首先要说明一点,这些图片并不是AI凭空画的,而是采取了一种更简单省事的方法:

从现成的图库里找出一些构图相似的,拿来改一改。

这里的图库,叫做GraphMovie数据集,数据来源是一些影评网站。

但是数据集里的图很多,怎么才能用AI自动的找出最符合你故事的图片呢?

这里用到了一个模型,叫做情景感知密集匹配模型(Contextual-Aware Dense Matching model,CADM)。

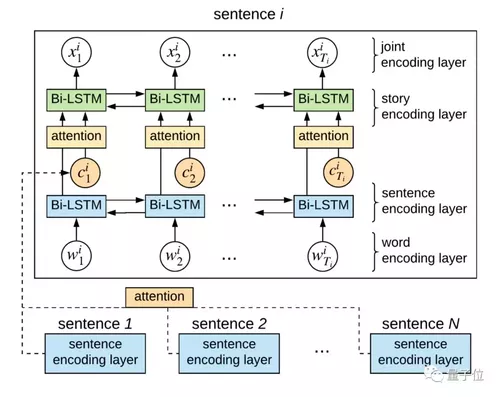

它长这样:

根据故事的内容,CADM找到了这样的一些图像:

另外,还有一个模型叫做No Context,它是此前“看字找图”这个领域中表现最好的AI。

No Context也找了一些图像出来:

不过,图还是有点少,人家好歹也是个完整的故事,你总不能拿这么几张图就讲完,这样故事没有细节,读者的体验也不好。

现在,请出第三个模型:贪婪解码算法,它负责根据故事里的细节,再找找能用上的图。

让它出马来补一补之后,故事立马就完整了:

把图片的画风统一

不过,就这样的效果,你会看得糊里糊涂,好像并不能传达出前面文本里的故事。

问题出在哪儿呢?

第一个问题是,图片里有许多背景、环境等相关元素,跟故事主线毫无关系,看到它还会影响你对故事的理解。

需要把这些冗余元素删掉,这里用到了何恺明的成名作Mask R-CNN,进行区域分割,删掉图片中和故事不相关的部分。

现在,这些图片长这样:

第二个问题,这些图片的画风实在是差异太大了,把这样的漫画拿出去,会被读者打的。

所以,需要把图片的样式统一起来,这里用到了一个工具CartoonGAN,从字面意思就可以理解,这是一个让图片变成卡通风格的GAN(生成对抗网络)。

在卡通GAN处理之后,这组图片变成了这样:

似乎好了一些,但是还有一个大bug:这些人长得不一样呀!你说他们是同一个故事的主角,打死我也不信。

于是,第三个问题来了,怎么才能让这些人都长成一个样?

这里,研究者们直接找了一个软件,叫做Autodesk Maya,是一个在电影里处理3D图像的软件,靠它制作出3D的场景、人物和道具,用半手动的方式把9张图片里的人全变成一个样。

不过论文作者表示,未来这个制作3D图像的过程有望全自动生成。

这一顿操作,是真的猛如虎,9张八竿子打不着边的图,现在画风一致、故事流畅,甚至还补充了背景和美化。

在电影工业中有大用途

其实,这样生成的“漫画”并不是最终结果。

它其实是用来拍电影的。

拍电影的准备过程中,需要一个Demo叫做“故事板(storyboard)”。

借助故事板,电影人在创作的过程中就可以先改Demo,定下来之后再完成成品,把撕逼的过程放在前面,防止做完之后甲方爸爸再提修改意见,导致工作量急剧提升。

因此,像这篇论文里这样,自动生成故事板,就可以节约电影人的许多时间,提高创作者们的生产效率。

人大博士出品

这篇论文的作者团队非常庞大,一共9位作者,分别来自中国人民大学、微软和北京电影学院。

一作陈师哲目前在人大读到了博士五年级,也是曾在微软小冰团队实习,还曾经赴CMU和阿德莱德大学访学。

她也是一位学术达人,仅仅今年一年,包括这篇论文在内就已经发了三篇顶会一作。

另外,微软小冰团队首席科学家宋睿华也参与到了这项研究中。

宋睿华博士毕业于清华大学,长期研究短文本对话与生成、信息检索与提取等领域,曾担任SIGIR、SIGKDD、CIKM、WWW、WSDM等会议的程序主席或高级程序主席。

共同学习,写下你的评论

评论加载中...

作者其他优质文章