鱼羊 安妮 发自 凹非寺

量子位 出品

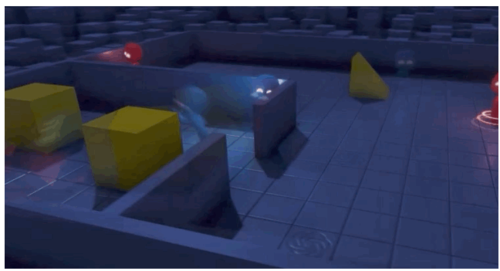

蓝色小人努力隐藏,而红色小人在复杂的地形中苦苦寻找,这场不是你死就是我活的对抗,不是CG动画,而是:

OpenAI的智能体真的在玩捉迷藏。

这是一项正经的研究,目的在于让AI自己学会合作和对抗。而事先连游戏规则都不给,全靠AI自己去探索。

由于展示效果看起来优秀得一塌糊涂,网友甚至开始怀疑OpenAI的身份了。

有推特网友表示:

实际上,OpenAI是一家动画公司。

还有网友表示惊叹:

哦买嘎,这制作质量、背景环境、甚至智能体的面部表情等都很可爱。这到底是篇科学论文,还是迪士尼里的未来世界主题公园里开辟了一处AI新景点?

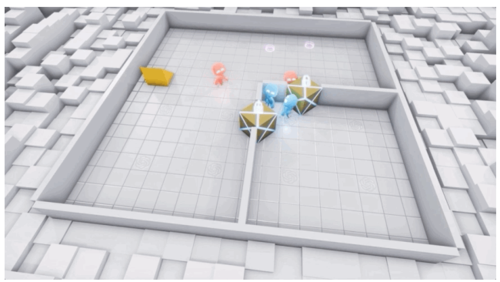

这项已经开源的大型AI捉迷藏博弈研究中,场景炫酷,每一个智能体都有自己的想法:

团队之间相互协作,与外部进行联合对抗……

这些智能体是不是都有生命了?

AI怎么玩捉迷藏游戏?

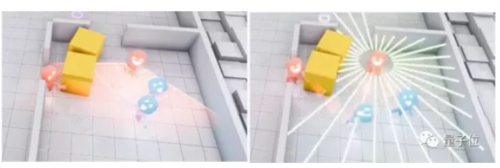

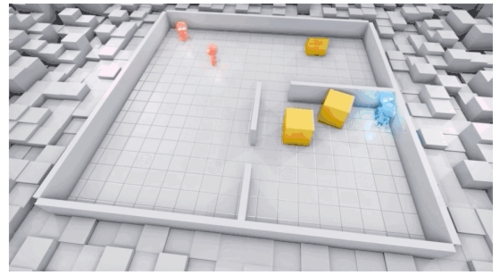

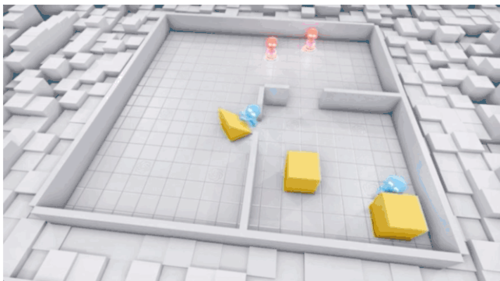

在这个捉迷藏游戏中,小红人是“鬼”,自带小雷达,能满场疯狂追击。

△红鬼还能推开箱子

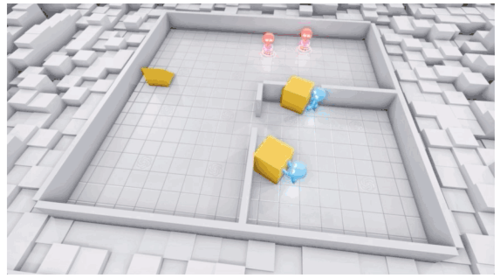

而小蓝人的任务很简单,就是跑。

比起自带传感器的鬼们,他们的技能是利用箱子这样的物体制造障碍,还能将之锁定。

起初,AI们完全不知道自己能做什么,只是出于“本能”逃跑、追逐。

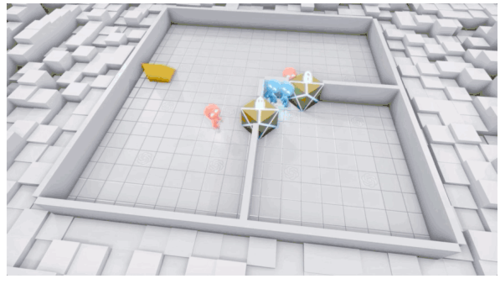

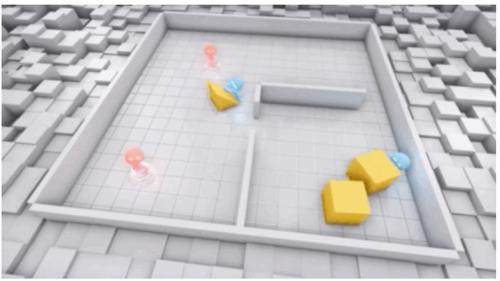

但在2500万次游戏之后,小蓝人学会了通过移动箱子,建造庇护所,来保护自己不被发现。

魔高一尺道高一丈。又经过了7500万场比赛,红鬼们会利用坡道闯进庇护所了!

又吃了1000万次亏之后,小蓝人们再建庇护所,知道把坡道也顺走了。

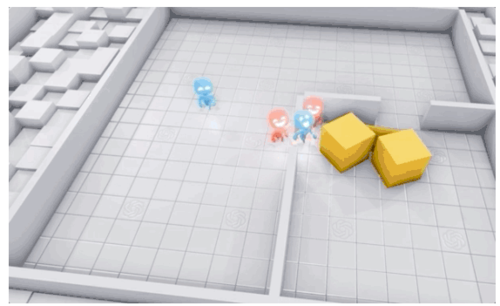

更厉害的是,AI们不只会单兵作战,还学会了团队协作。

看看小蓝人这个协作水平,那真是行云流水,无缝衔接,还很讲究策略:

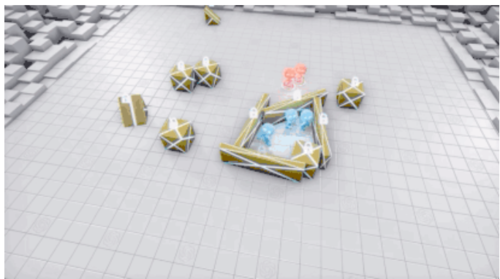

什么,你觉得地形太简单?在将近5亿次训练之后,AI们解锁了更复杂的版本:

这群AI,可真是太秀了。

捉迷藏の奥义

再强调一次,以上不是CG,不是CG,不是CG。

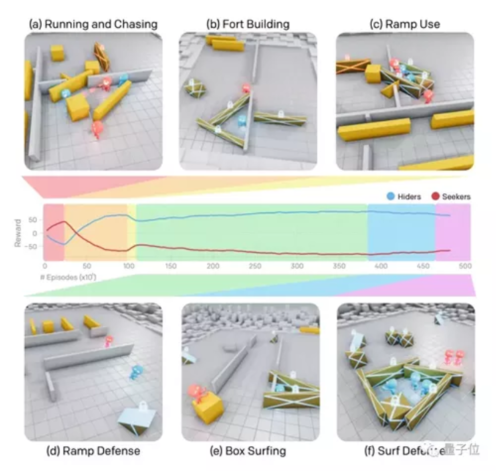

这是来自OpenAI的一项新研究。通过多智能体竞争,和捉迷藏这样一个简单的目标,以及标准的强化学习算法,研究人员们发现,在没有事先学习规则的情况下,AI们自己创造了一个自我监督的自动课程(autocurricula)。

这其中,既包含多轮不同的紧急策略,也包括复杂的工具使用和团队协调。

所谓课程(curricula),可以被视为一系列挑战。而自动课程(autocurricula)就是指,每个挑战都是由系统本身产生的。(这一概念由DeepMind提出,论文地址见文末)

△AI们在训练过程中发现了多达六种独特的策略

并且,环境变复杂,AI们的表现反而更加强大。与其他自我监督的强化学习方法相比,这群AI的行为更像人类。

OpenAI称之为无目标探索。

AI们事先并没有学过捉迷藏的游戏规则,而是凭借对游戏世界的理解自由发展。

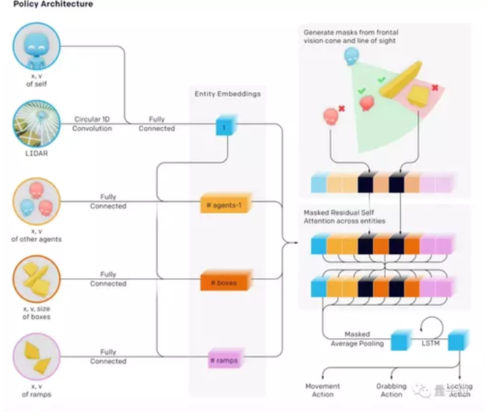

为了实现这一点,研究人员利用了以实体为中心的观察(observation),并采用注意力机制来捕获对象层信息。

在设定的环境中,每个智能体都根据自身的观察和隐藏内存状态独立行动。

每个物体都会被嵌入,并通过一个有遮挡的剩余自注意块(residual self attention block),在这其中,注意力集中在物体上,而不是随着时间改变。

那些就在智能体面前,但并不在其视线之内的物体则会被屏蔽掉,这样智能体就捕捉不到它们的信息了。

智能体的策略是通过左右互搏(self-play)和近端策略优化训练出来的。在优化期间,智能体可以在其值函数中使用有关被遮挡物体和其他智能体的特权信息。

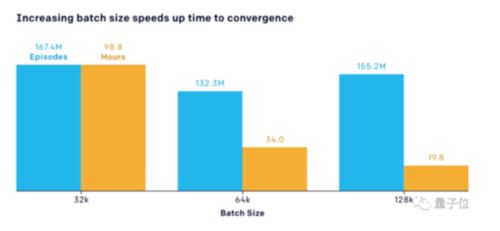

此外,大规模训练效果显著。增加批量大小可以大大加快收敛速度,并且不会对样本效率产生太大的影响。

这样训练出来的AI,到底鲁棒不鲁棒呢?

光说不练假把式,不如来一套智力测试练练手。

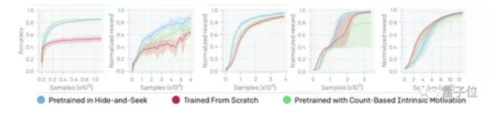

OpenAI的研究人员设计了一套涵盖五个基准智力测试的考题,主要分为两个领域:认知和记忆。

物体计数任务:测试智能体是否对物体具有持久的感知(即,能理解即使无法察觉,事物仍然存在这一点)。

锁定和返回:测试智能体是否可以在执行新任务时记住其原始位置。

顺序锁定任务:4个箱子被按指定顺序放置在3个没有门的随机房间中,但每个房间都有一个坡道。智能体必须在没有进行过观察的前提下,按照特定顺序锁定所有的箱子。

蓝图构建任务:智能体必须把房间中的箱子放到指定的四个目标位置。

避难所建设任务:智能体必须在圆筒周围用箱子造一个避难所。

结果表明,在锁定和返回,顺序锁定和蓝图构建这三个任务当中,在捉迷藏环境中预训练过的AI,表现优于基线方法。但在对象技术和住房建设方面表现得要差一些。

△蓝线为在捉迷藏环境中预训练过的AI

不限于游戏场景

这项研究引发了大量网友围观,不到一天时间,推特已经超过2000赞。

一位软件工程师感慨,这项研究直戳智能体对齐问题(Alignment Problem)的难点,即使是在捉迷藏这种简答的任务中,AI可能也有让人意想不到的行为。

HackerNews上网友表示,更酷的是这项研究此后可用于真实世界的机器人,让他们学习去克服挑战。

OpenAI自己也站出来直言,这项研究带动了四个方向的研究。

一是证明了在智能体决策中,多智能体自动课程是导致很多不同和混合相转移的原因之一。

二是验证了,当模拟真实物理环境中引导智能体行为时,多智能体自动课程可训练出类似人类的技能,比如借助工具达到目的。

三是,这项研究还提出了一个在开放环境中评价智能体的框架,以及一套有针对性的智能体智力测试。这对于之后的智能体研究有一定参考意义。

最后,这项研究还将环境与构建环境的代码进行了开源,将鼓励对基于物理环境的多智能体自动课程的进一步研究。

简单的规则、多智能体竞争以及标准的大规模强化学习算法,原来可以激励智能体在无监督方法下学习复杂的策略和技能。

而往前看看,研究的意义又不仅限于理论研究阶段,或局限于游戏场景,而是会覆盖到日常生活的方方面面。

外媒VentureBeat在报道时,引用了DeepMind哈萨比斯对游戏AI的看法:

游戏AI是通往通用AI的垫脚石。我们研究这些游戏的真正原因是,它是研发算法的一个非常方便的试验场。

我们正在开发一种算法,可以将其转化到现实世界中来,用于解决真正具有挑战性的问题,并帮助这些领域的专家。

无论是DeepMind还是OpenAI,在用游戏的方式训练出可以在真实场景里应用的技术,又何尝不是创造了一个小小世界呢。

姚班毕业生参与

这篇论文出自OpenAI的Bowen Baker、Ingmar Kanitscheider、Todor Markov、Yi Wu、Glenn Powell、Bob McGrew和Google Brain的Igor Mordatch之手。

一作Bowen Baker本科与硕士都毕业于电气工程与计算科学专业,自2017年12月开始就职于OpenAI,担任研究科学家一职,主要针对多智能体领域进行研究。

作者团队中还有一位年少有为的中国研究人员吴翼(Yi Wu),他是2010级清华大学姚班毕业生,又一华人图灵奖得主姚期智教授的桃李门生。

作为“半国英才聚清华,而清华一半英才在姚班”的姚班一员,吴翼在本科期间就打卡了微软、Facebook、今日头条等互联网大厂,实习经验丰富。

2014年到2019年,吴翼奔赴加州大学伯克利分校,攻读人工智能专业,主要研究方向为将深度强化学习、自然语言处理和概率编程。

吴翼已经在各类AI顶会上发表论文十多篇,IJCAI 16、AAAI 17、EMNLP 17、ICML 18、NIPS 18等会议都有他的研究出现,今年,吴翼还参与了两篇AAAI 19 Oral论文的研究。

吴翼还在各项竞赛中崭露头角,还是ACM/ICPC北美冠军、世界总决赛银牌,IOI2010银牌得主。

清华大学交叉信息研究院网站和吴翼个人简历显示,吴翼将于明年入职,这位28岁年少有为的学霸,将担任清华大学交叉信息科学研究院的助理教授。

姚班出身,回归姚班,不仅是收获季节,也是一段薪火相传的一段佳话。

吴翼个人履历:

https://jxwuyi.weebly.com/contest-and-interest.html

传送门

博客:

https://openai.com/blog/emergent-tool-use/

代码:

https://github.com/openai/multi-agent-emergence-environments

HackerNews:

https://news.ycombinator.com/item?id=20996771

VentureBeat报道:

https://venturebeat.com/2019/09/17/openai-and-deepmind-teach-ai-to-work-as-a-team-by-playing-hide-and-seek/

论文Autocurricula and the Emergence of Innovation from Social Interaction: A Manifesto for Multi-Agent Intelligence Research:

https://arxiv.org/pdf/1903.00742.pdf

— 完 —

共同学习,写下你的评论

评论加载中...

作者其他优质文章