车栗子 发自 凹非寺

量子位 报道

如何欺骗一只特斯拉?

只要在地上摆几张小贴纸,像上面的红点这样排成一行。

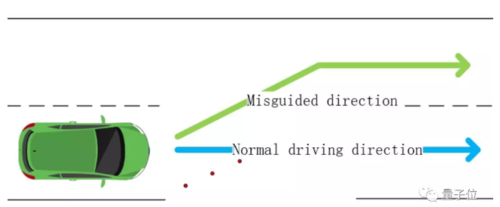

辅助驾驶系统Autopilot就会以为路歪了,把车拐到反向的车道上去:

就是这样轻易地被骗了。

虽然,今天是愚人节,也请各位千万不要模仿。

这是腾讯科恩实验室,在特斯拉Model S身上做的自动驾驶安全性研究,软件版本是2018.6.1。这也是科恩实验室第一次在特斯拉量产车上做自动驾驶实验。

研究报告已经发布。包括误认车道在内,腾讯指出了Autopilot的三大缺陷。

三连骗

第一,不下雨也能骗它打开雨刷器。不要小看这一骗。

这项测试的场地是车库,理论上不会下雨。

不过,只要在特斯拉眼前播放干扰画面,展开对抗攻击:

特斯拉便以为在下雨了。而且,从雨刷挥舞的频率来看,还不是绵绵细雨。

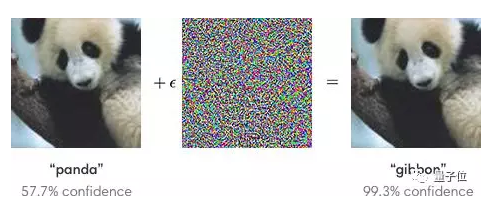

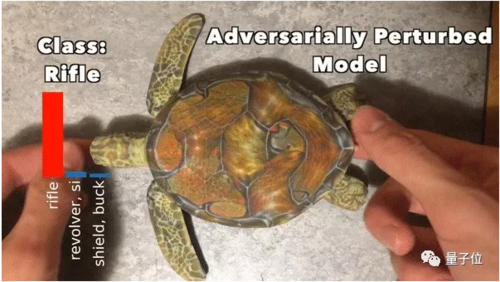

有特殊纹理的图像,是可以欺骗图像识别系统的。

并且,只要偷偷加入定制的噪音 (下图中间) ,便可以在人类没有察觉的情况下,骗倒一只AI:

熊猫被认成了长臂猿;乌龟成了步枪,而且翻过来调过去都是步枪。

所以,骗开雨刷器有什么危险?

特斯拉的图像处理工具,都是身兼数职的:追踪其他车,追踪物体和车道,为周围环境画地图,以及估计雨量……

并且,腾讯团队惊讶地发现,刚才这些任务里面,大多数都是只靠单一神经网络来完成的。

这是不是说,一挂挂一片?

第二,就是开头提到的,车道识别容易被干扰。

也不需要定制对抗图像,只要在地上有规律地摆上贴纸而已。从车里看是这样:

Model S拐上了反向车道,打方向盘的时候,丝毫没有犹豫。

即便,没有人真的用这样的方法破坏交通安全,路上如果出现了小小的异物 (比如鸟粪) ,不知道会怎么样。

第三,游戏手柄能远程操控。

把恶意代码动态地插到Cantx服务里面,钩住 (hook) 里面的方向盘函数。

这样,腾讯团队黑进了Autopilot的控制系统。

后来,在手柄的支配下,汽车就开始左冲右突了。

特斯拉回应

关于腾讯提出的三大隐患,特斯拉一一回应。

第一,关于骗开雨刷器的方法,特斯拉说:

这是要在车前放一个屏幕,不是司机面临的现实情况,也不是安全问题。而且,用户手册写明了,雨刷器的控制目前处于测试阶段,用户可以随时调整到手动控制模式。

第二,关于在路上贴贴纸,特斯拉说:

这是手动改变汽车所处的物理环境,才让特斯拉的行为发生了变化。在现实情况下,人类驾驶员的操作可以覆盖住Autopilot的决策,驾驶员也应该随时准备好,不管是控制方向盘还是刹车。所以这也不是问题 (测试视频里,驾驶员没有干预) 。

第三,关于远程黑进系统,特斯拉说:

报告里面提到的漏洞,特斯拉在2017年的安全更新中,已经修复了。2018年又更新了一次。两次都是在这个报告发表之前。许多年来,也没有一个用户表示自己受到过这个问题的影响。

2016年,腾讯的科恩实验室也曾经远程黑进特斯拉的系统,发现了许多漏洞。特斯拉还公开对腾讯团队表示了感谢。

后来,特斯拉便开始对Autopilot进行一系列的安全更新。

不过,似乎并没有阻止接连不断的事故。

报告传送门:

https://keenlab.tencent.com/en/whitepapers/Experimental_Security_Research_of_Tesla_Autopilot.pdf

— 完 —

共同学习,写下你的评论

评论加载中...

作者其他优质文章